转自 专知

近几年来,人工智能技术得到了飞速发展,其进展突出体现在以知识图谱(Knowledge Graph)为代表的知识工程和以图神经网络(Graph Neural NetWorks, GNN)为代表的深度学习等相关领域。融合知识图谱与图神经网络已然成为研究人员进一步完善知识图谱学习与提升图神经网络模型推理能力的重要技术思路。

知识图谱是以图的形式表现客观世界中的实体及其之间关系的知识库,实体可以是真实世界中的物体或抽象的概念,关系则表示了实体间的联系。因此,知识图谱能够以结构化的形式表示人类知识,通过知识表示和推理技术,可以给人工智能系统提供可处理的先验知识,让其具有与人类一样的解决复杂任务的能力[1~3]。如何更好地构建、表示、补全、应用知识图谱,已经成为认知和人工智能领域重要的研究方向之一。

图 神 经 网 络 的 概 念 最 早 于 2005 年 由 戈 里(Gori)等人[4] 提出,是一种专门用于处理图结构数据的神经网络模型。使用图可以更准确和灵活地对现实应用中的数据建模,如在电子商务领域中的用户 – 产品交互图、化学领域的分子图、医药领域的药物副作用图等。因此,研究者们设计了多种图神经网络模型,包括图卷积网络(Graph Convolu-tional Network,GCN)[5~7]、图注意力网络(Graph Attention Network,GAT)[8] 等。此外,由于异质图具有更灵活的建模和融合信息的能力[9],研究者们还尝试设计和应用基于异质图的图神经网络模型[10~12]。如何设计更合理的图神经网络模型,使信息沿着图结构更合理地传播,从而提升模型对图结构数据的拟合能力,是人工智能领域的一个热点问题。

近年来,描述常识和事实的知识图谱成为了学术界和工业界广泛使用的知识表示方式,图神经网络在信息传播、关系归纳偏置上也展现了优秀的性能[13]。考虑到知识图谱本身恰好就是一种图结构数据,因此采用图构建知识和数据之间的关联,同时应用图神经网络技术,有望结合知识和数据实现更好的可解释和可信人工智能技术。一方面,利用图神经网络在学习节点、边表示上的优势,可以更好地学习知识图谱的实体、关系的嵌入表示,改善关系抽取等任务,帮助构建知识图谱,以及提高链接预测等任务,帮助补全知识图谱 ;另一方面,利用图神经网络在信息传播和推理上的优势,可以更有效地在应用任务中引入知识图谱中的信息,从而改善如文本挖掘、推荐系统、计算机视觉等领域中的应用效果,提供可解释的模型。

本文将对知识图谱与图神经网络模型相融合的方法及应用进行综述。主要包括以下内容:

1 基于图神经网络的知识图谱学习与计算

由于知识图谱可以表征实体之间结构化的关系,如今已经成为认知和人工智能领域重要的研究方向。图神经网络利用深度神经网络对图数据中的拓扑结构信息和属性特征信息进行整合,进而提供更精细的节点或子结构的特征表示,并能很方便地以解耦或端到端的方式与下游任务结合,巧妙地满足了知识图谱对学习实体、关系的属性特征和结构特征的要求。本节主要从知识图谱中的5个典型任务介绍基于图神经网络的知识图谱学习方法。

知识图谱表示学习

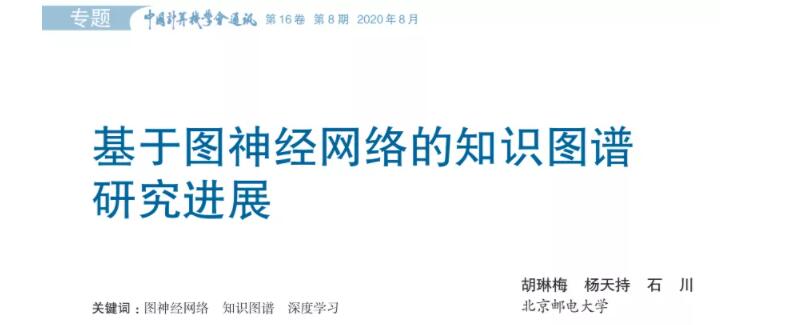

知识图谱表示学习,即为知识图谱中的实体和关系学习出一个低维度的向量表示,同时包含一些语义信息,从而得以在下游任务中更加方便地提取和利用知识图谱中的信息,例如链接预测[10]、常识问答[1]等。通过应用图神经网络,在学习知识图谱的表示时,每个实体都将利用到与其相关的其他实体中的信息,打破了彼此之间的孤立性,从而学得更完整更丰富的实体、关系表示。

信息抽取

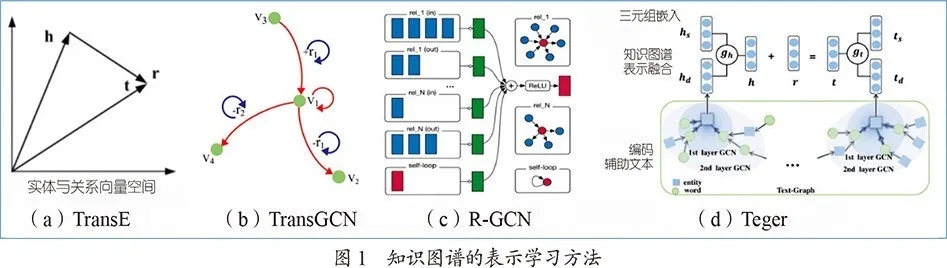

信息抽取是指从非结构化、半结构化文档或句子中提取结构化信息的技术,与知识图谱的构建有着密切的联系,主要包括命名实体识别、实体消歧、关系抽取、指代消解等任务。近年来,已有许多研究将图神经网络应用于知识图谱的关系抽取任务,而在其他任务上对图神经网络的探索还较少。通过图神经网络可以对句子内或句间词与词的关联关系进行有效建模,从而更准确地捕捉实体间的关系。

实体对齐

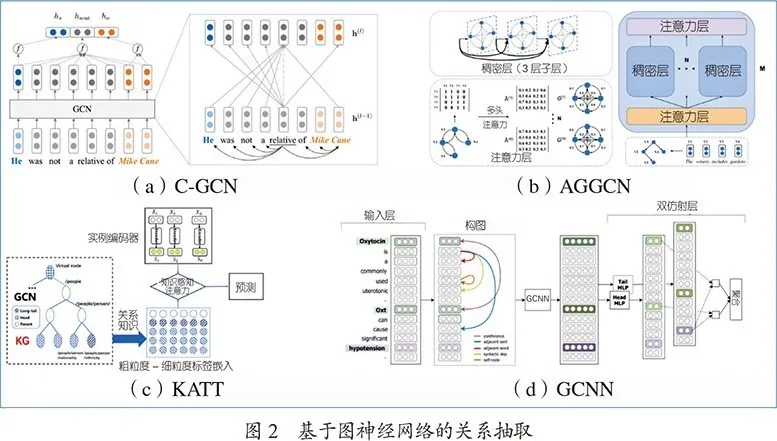

实体对齐是将从知识图谱中学习到的描述同一目标的实体或概念进行合并,再将合并后的实体集与开放链接数据中抽取的实体进行合并,旨在融合多个知识图谱形成一个更完整的知识图谱。由于图神经网络具有识别同构子图的能力[24],而可对齐的实体对周围通常有相似的邻居,即具有一定的同构特征,因此目前有许多研究者尝试将图神经网络用于实体对齐。

链接预测

链接预测是用于预测知识图谱中实体对之间所缺少关系的任务,具有广泛的应用范围,旨在解决知识图谱不完整的问题。链接预测与知识图谱表示学习有着不可分割的联系,一方面表示学习通常需要用链接预测评价优劣[10, 15],另一方面链接预测的模型通常也会学得实体和关系的表示。许多工作利用图神经网络为实体引入邻实体和对应关系的信息,学得更全面的实体表示,从而更准确地预测实体之间的链接关系。

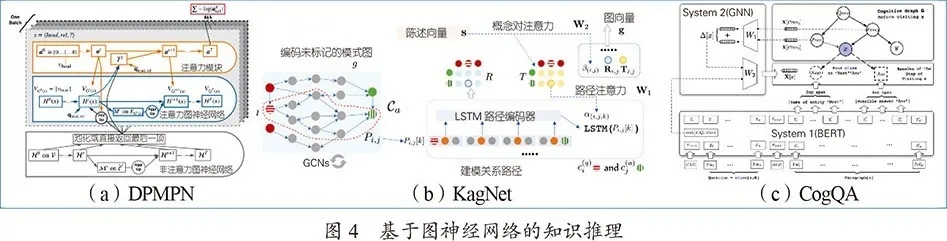

知识推理

与链接预测相似,知识推理是从给定的知识图谱中推导出实体与实体之间的新关系,但知识推理所获得的关系通常需要在知识图谱中进行多跳的推理过程。知识推理是一些下游任务的重要支撑之一,如知识库问答[1~3]。由于图神经网络在推理能力上的优势[13],近年来被一些研究者尝试用于知识推理任务。

2 基于图神经网络的知识图谱应用

描述常识和事实的知识图谱是学术界和工业界广泛使用的知识表示方式,采用图构建知识和数据之间的关联,是一种直接且有效的将知识和数据结合的方式。受益于图神经网络技术在信息传播和推理上的优势,知识图谱中的先验知识被有效地引入到应用任务中。

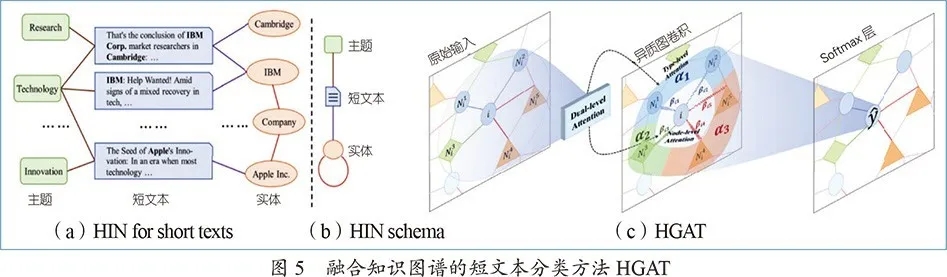

文本挖掘

知识图谱由自然语言构建而来,因此与文本挖掘的联系颇深。知识图谱在大部分的文本挖掘任务中都有大量的应用,其中应用最广泛的是知识库问答任务。在文本分类、文本生成等任务中,知识图谱也都扮演了非常重要的角色。

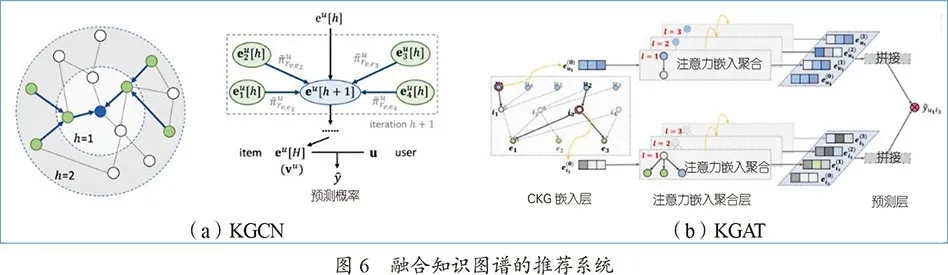

推荐系统

为了解决推荐系统中的稀疏性问题和冷启动问题,一种可行的思路是将知识图谱作为外部信息整合到推荐系统中,使推荐系统具有常识推理能力。研究者们基于图神经网络强大的聚合信息以及推理能力,设计了基于图神经网络和知识图谱的推荐系统,有效地提升了推荐命中率。此外,图神经网络的信息传播与推理能力也为推荐结构提供了一定的可解释性。

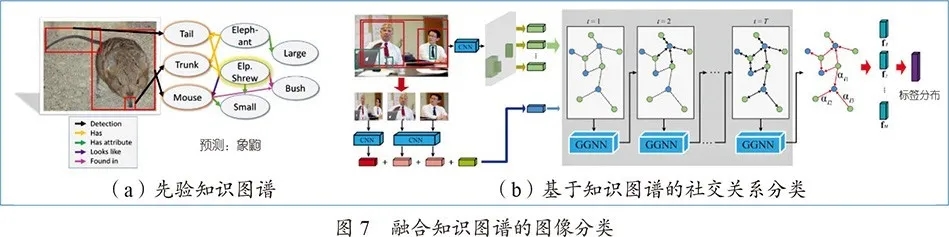

计算机视觉

人类区别于现代计算机视觉算法的一个特征是获得知识并使用该知识推理视觉世界的能力,从而可以通过很少的例子认知视觉世界[49]。研究者们考虑到图神经网络在学习节点和边的表示方面的优势,应用了图神经网络来学习利用图像中的目标与知识图谱之间的关联关系。

3 总结与展望

结合知识图谱和图神经网络的相关研究已经成为人工智能领域的一个热点方向。知识图谱可以为各类学习任务提供良好的先验知识,图神经网络则可以更好地支持图数据的学习任务。但是,目前基于图神经网络的知识图谱学习、计算与应用的研究都还相对较少,未来仍有巨大的发展空间,例如基于图神经网络的知识图谱自动构建、基于异质图神经网络的知识融合、基于元路径或图神经网络的知识图谱复杂推理、基于图神经网络的可解释性学习等。

自动构建 当前的知识图谱高度依赖于人工构建,构建特定领域的知识图谱又是企业应用里不可或缺的现实需求。在学习建模实体的时间信息和实体动力学方面,已有一些基于传统深度学习的工作,但通常无法将知识图谱作为一个整体对其动态性进行建模。因而,利用最近的一些动态图神经网络的方法例如图时空网络,同时建模并预测微观层面上的实体以及宏观层面上的图谱的变化规律,是一个值得关注的方向。

融合知识 采用图构建知识和数据之间的关联从而引入知识图谱,是目前研究的一种主流思路之一。通常,真实数据中的交互关系有丰富的属性特征(如用户–商品交互图中用户和商品都带有丰富的属性特征),而知识图谱则是关系特征丰富的,即相对更侧重于结构性。此外,知识图谱中的本体概念层包含大量的谓词逻辑规则知识,如何设计更合适的图神经网络模型弥补这三者之间的语义鸿沟,从而更好地融合知识图谱中的先验知识,将是一个研究难点。一种直接的思路是利用异质图神经网络的方法,考虑节点的异质性和多模态性,从而用适合各类型的不同方式对不同的信息进行融合。

复杂推理 由于基于嵌入的方法在复杂的逻辑推理上有局限性,因而可以进一步探讨关系路径和符号逻辑两个方向。异质图上的元路径定义了高阶的语义关系,而知识图谱可看作一种特殊的异质图,将基于异质图神经网络的消息传递与基于强化学习的路径查找和约减相结合,是一种可行的处理复杂推理的思路。研究者们最近的工作将概率图模型(如马尔科夫网)与图神经网络相结合,旨在消息传递时发现并推理逻辑规则,而利用此类模型挖掘知识图谱上的推理规则,也是一个值得注意的研究方向。

可解释性 深度学习的黑盒问题被人诟病已久,图神经网络的信息传播机制相较传统深度学习模型更具有可解释性。知识图谱提供了现实世界的事实知识,利用图神经网络模型尤其是概率图神经网络应用在知识图谱中实现逻辑推理,从而显式地生成基于知识图谱的推理路径,或许可以期待打开深度学习的黑盒。

部分参考文献

[1] Lin B Y, Chen X, Chen J, et al. KagNet: Knowledge-Aware Graph Networks for Commonsense Reasoning[C]// Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing, 2019: 2829–2839.

[2] De Cao N, Aziz W, Titov I. Question Answering by Reasoning Across Documents with Graph Convolutional Networks[C]// Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, 2019: 2306–2317.

[3] Ding M, Zhou C, Chen Q, et al. Cognitive Graph for Multi-Hop Reading Comprehension at Scale[C]// Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics, 2019: 2694–2703.

[4] Gori M, Monfardini G, Scarselli F. A new model for learning in graph domains[C]// IEEE International Joint Conference on Neural Networks, 2005, 2: 729–734.

[5] Bruna J, Zaremba W, Szlam A, et al. Spectral Networks and Locally Connected Networks on Graphs[A]. 2nd International Conference on Learning Representations[C]. OpenReview.net, 2014.

[6] Defferrard M, Bresson X, Vandergheynst P. Convolutional Neural Networks on Graphs with Fast Localized Spectral Filtering[A]. Advances in Neural Information Processing Systems 29[C]. Curran Associates, Inc., 2016: 3844–3852.

[7] Kipf T N, Welling M. Semi-Supervised Classification with Graph Convolutional Networks[A]. 5th International Conference on Learning Representations[C]. OpenReview.net, 2017.

[8] Velickovic P, Cucurull G, Casanova A, et al. Graph Attention Networks[A]. 6th International Conference on Learning Representations[C]. OpenReview.net, 2018.

[9] Shi C, Philip S Y. Heterogeneous information network analysis and applications[M]. Springer Berlin Heidelberg, 2017.

[10] Schlichtkrull M, Kipf T N, Bloem P, et al. Modeling Relational Data with Graph Convolutional Networks[A]. European Semantic Web Conference[C]. Springer, 2018: 593–607.

[11] Wang X, Ji H, Shi C, et al. Heterogeneous Graph Attention Network[A]. Proceedings of the 2019 World Wide Web Conference[C]. ACM, 2019: 2022–2032.

[12] Linmei H, Yang T, Shi C, et al. Heterogeneous Graph Attention Networks for Semi-supervised Short Text Classification[A]. Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing[C]. Association for Computational Linguistics, 2019: 4821–4830.

[13] Battaglia P W, Hamrick J B, Bapst V, et al. Relational inductive biases, deep learning, and graph networks[J]. arXiv:1806.01261 [cs, stat], 2018.