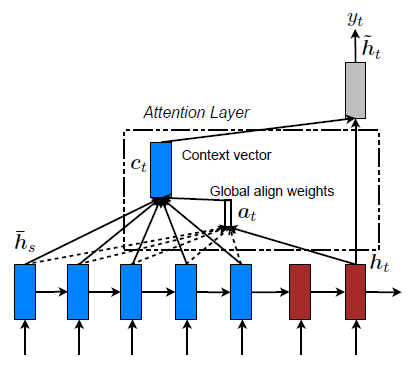

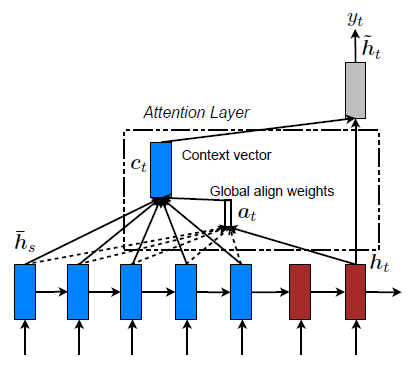

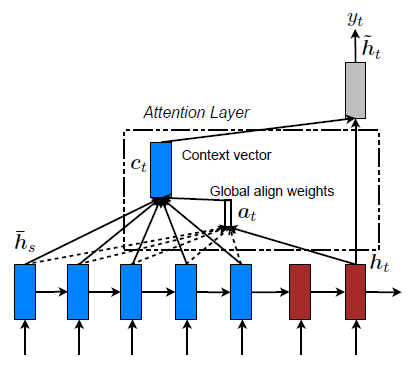

图8.4 全局注意力模型(Luong et al., 2015)

图8.4 全局注意力模型(Luong et al., 2015)

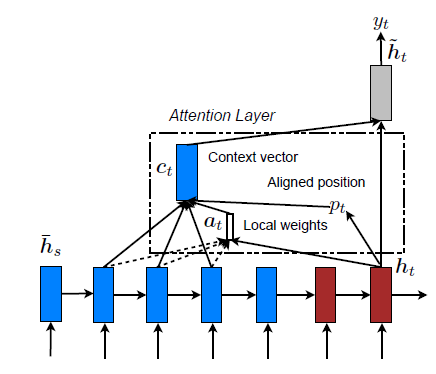

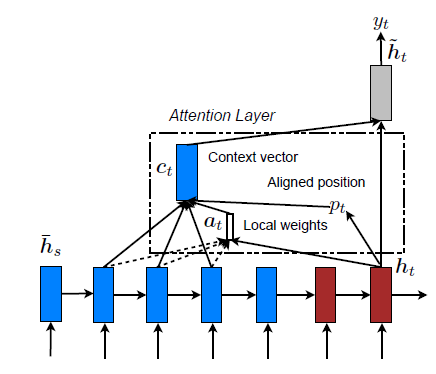

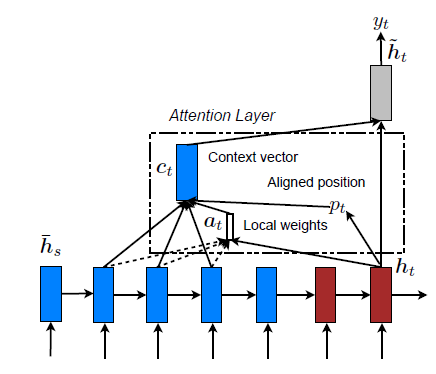

图8.5 局部注意力模型(Luong et al., 2015)

图8.5 局部注意力模型(Luong et al., 2015)

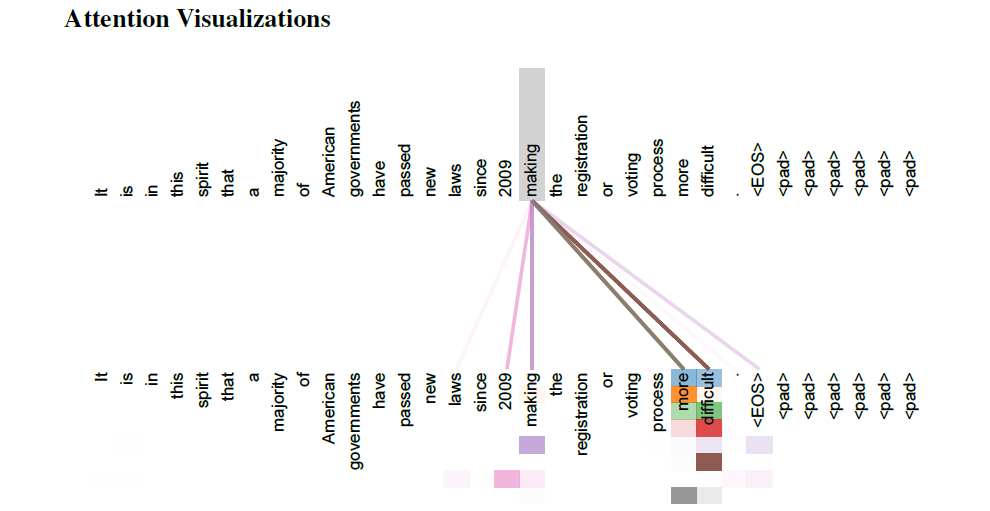

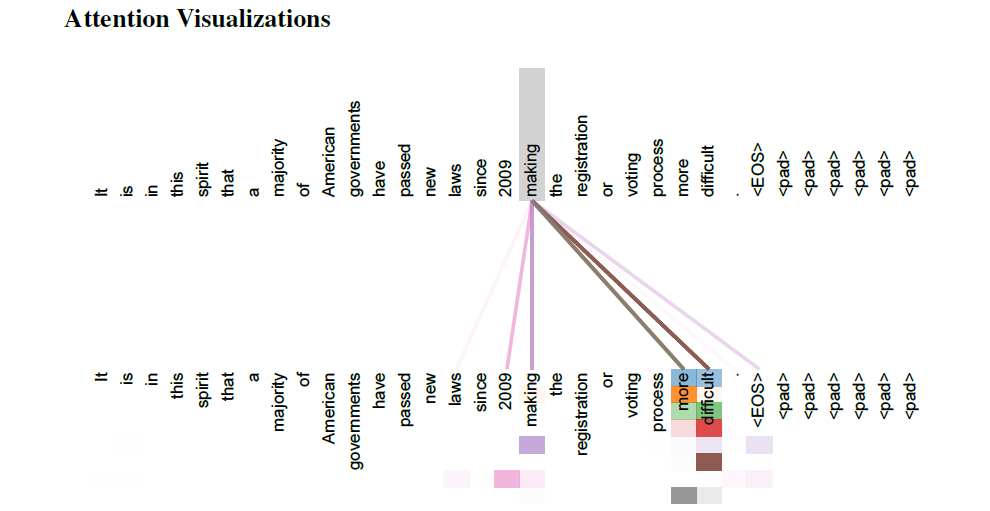

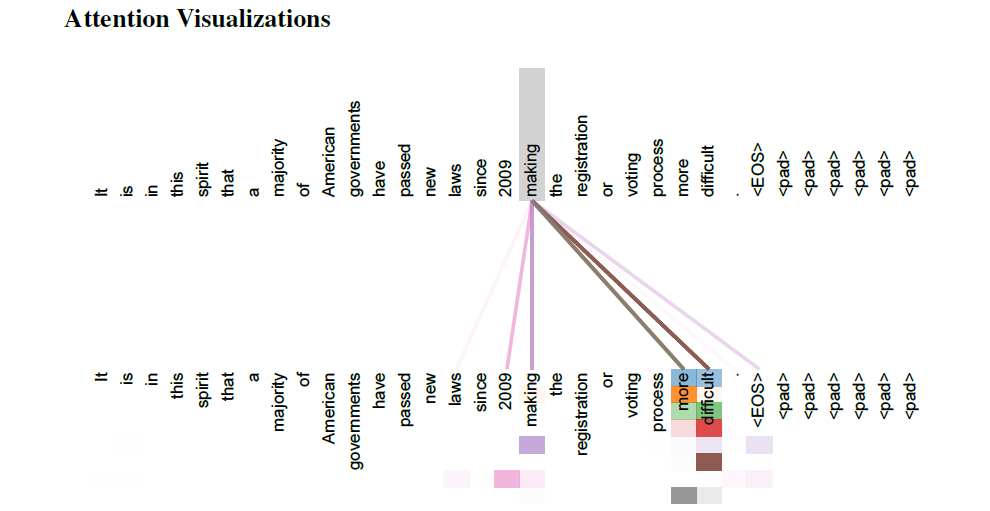

图8.6 在5或6层的self-attention中,远程依赖注意力机制的一个例子(Vaswani et al., 2017)

图8.6 在5或6层的self-attention中,远程依赖注意力机制的一个例子(Vaswani et al., 2017)

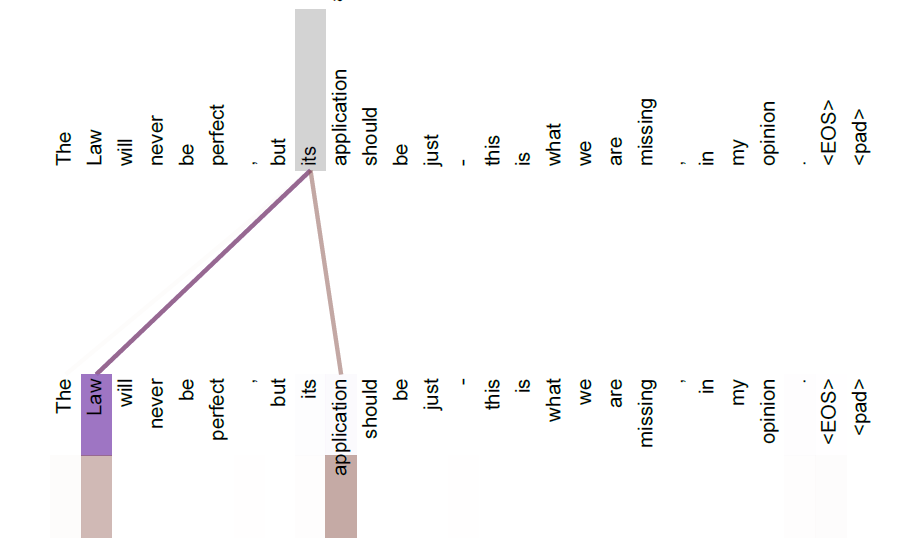

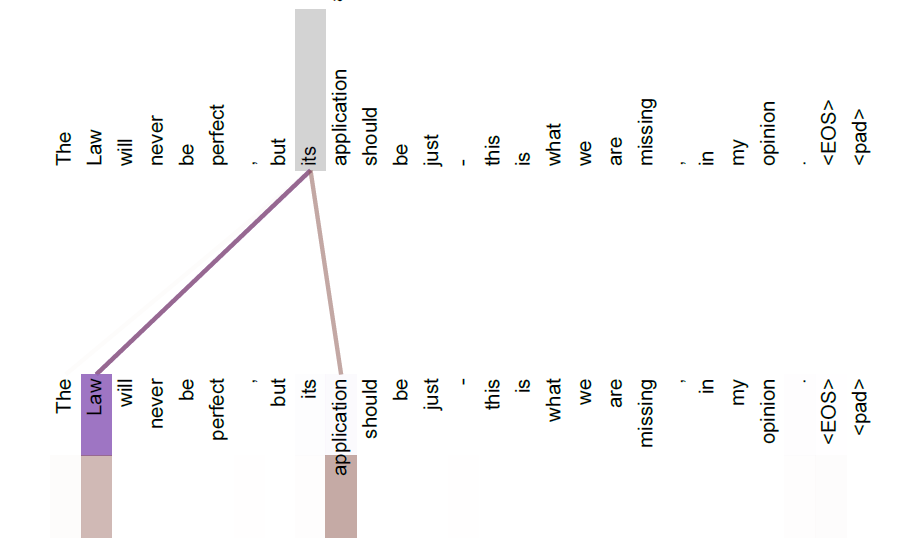

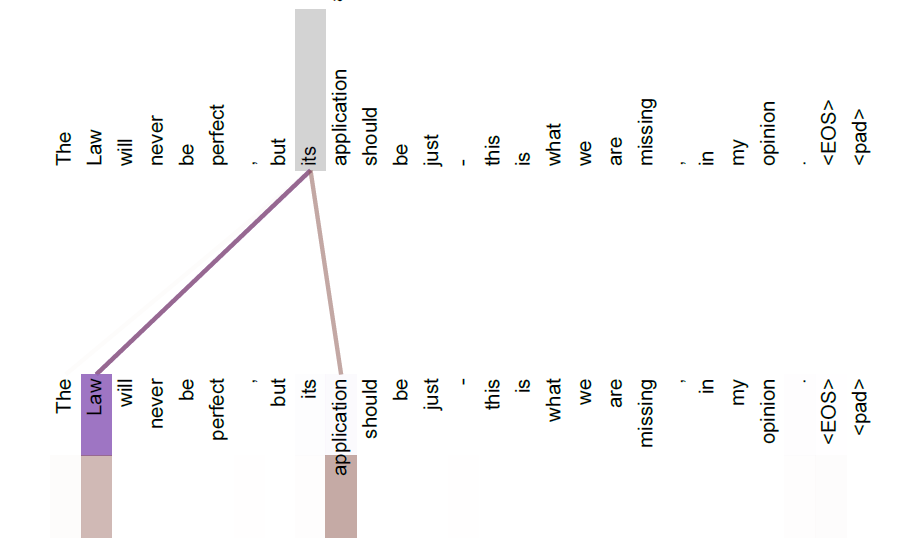

图8.7 一个注意力head的例子,解释了从“its”这个单词得到的注意力(Vaswani et al., 2017)

图8.7 一个注意力head的例子,解释了从“its”这个单词得到的注意力(Vaswani et al., 2017)

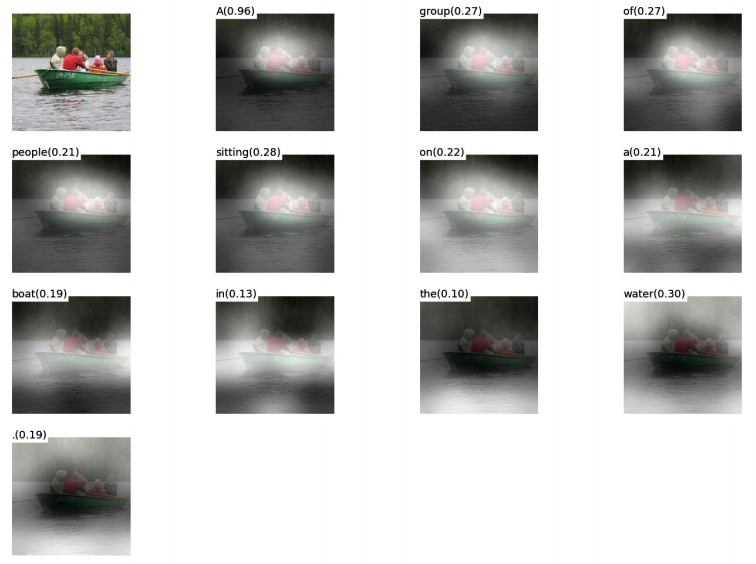

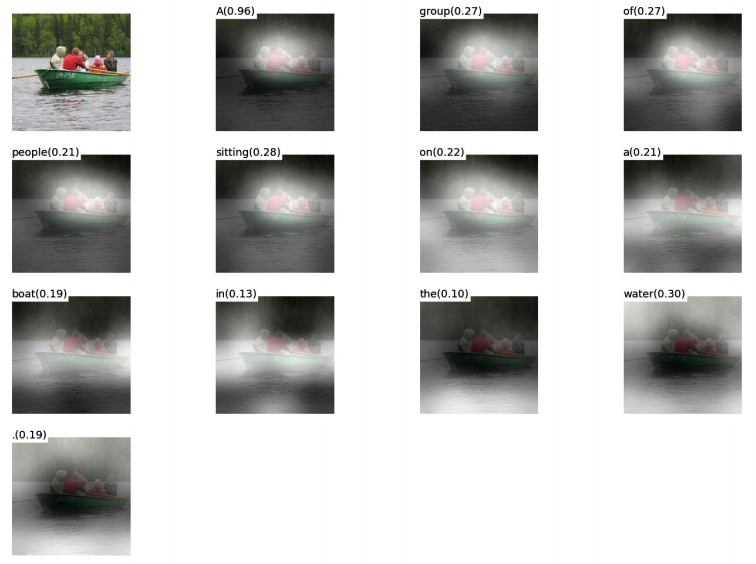

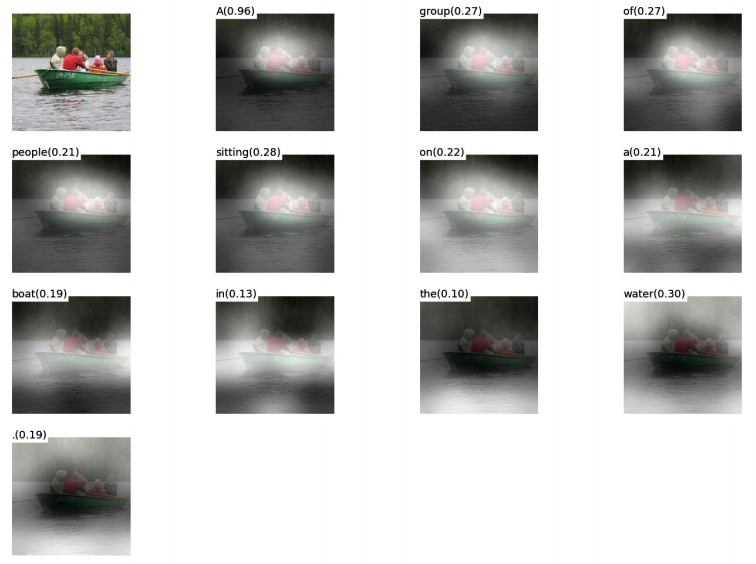

图8.14 一个可视化的例子,在这个白色区域表示模型所关注的位置,用基于item-wise的基于RNN的模型生成标题。左上角的单词是模型生成的单词(Xu et al., 2015)

图8.14 一个可视化的例子,在这个白色区域表示模型所关注的位置,用基于item-wise的基于RNN的模型生成标题。左上角的单词是模型生成的单词(Xu et al., 2015)

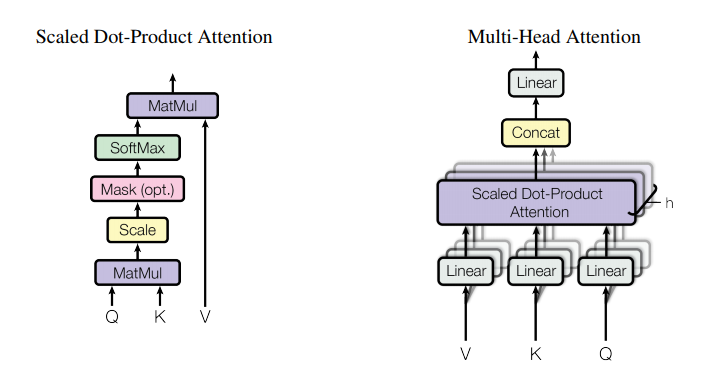

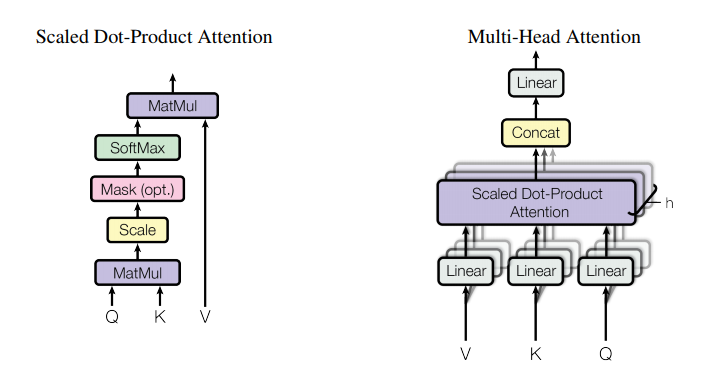

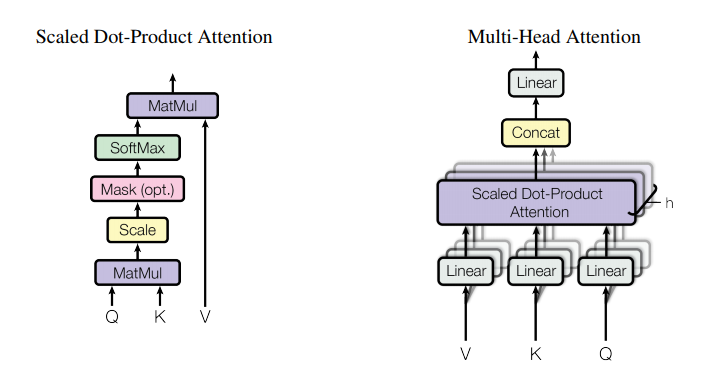

图8.16 左侧为scale点乘attention结构图,右侧为由几个平行的注意力层组成的multi-head注意力结构图(Vaswani et al., 2017)

图8.16 左侧为scale点乘attention结构图,右侧为由几个平行的注意力层组成的multi-head注意力结构图(Vaswani et al., 2017)

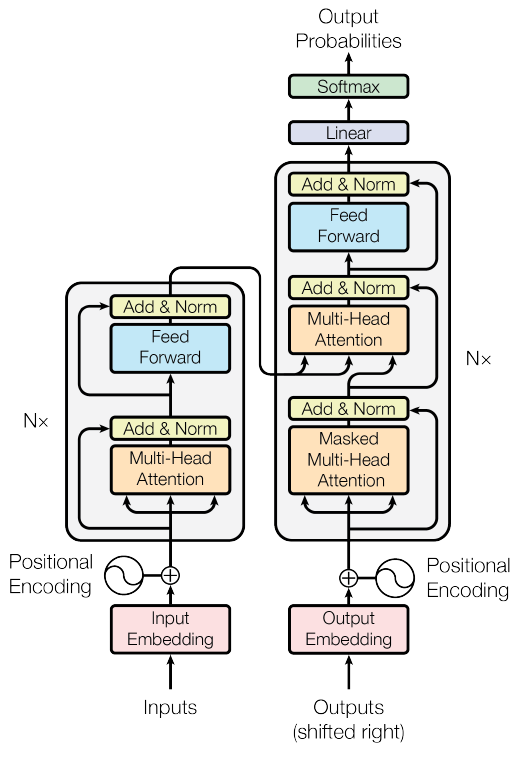

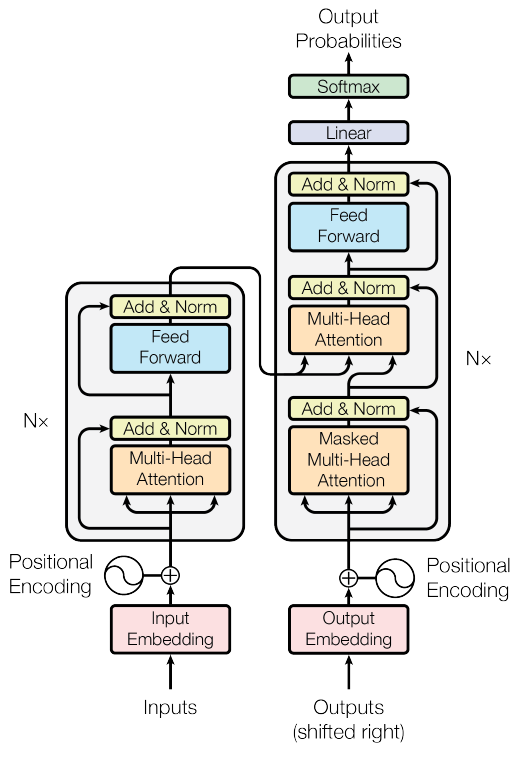

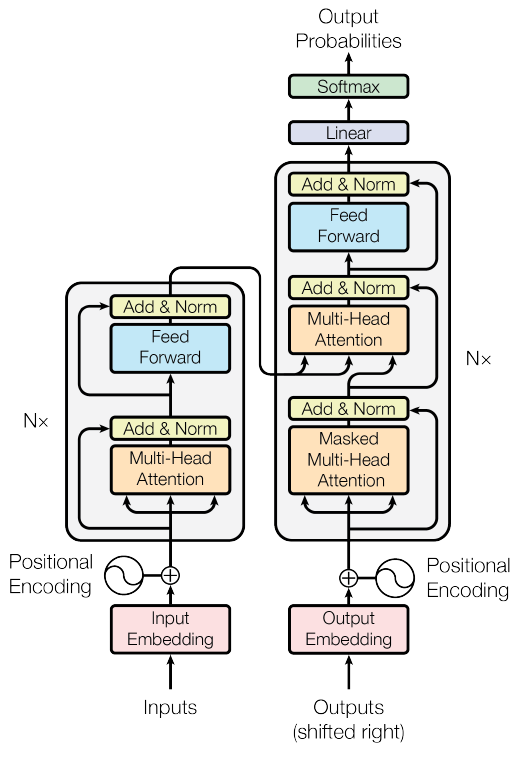

图8.17 转换模型机制(Vaswani et al., 2017)

图8.17 转换模型机制(Vaswani et al., 2017)

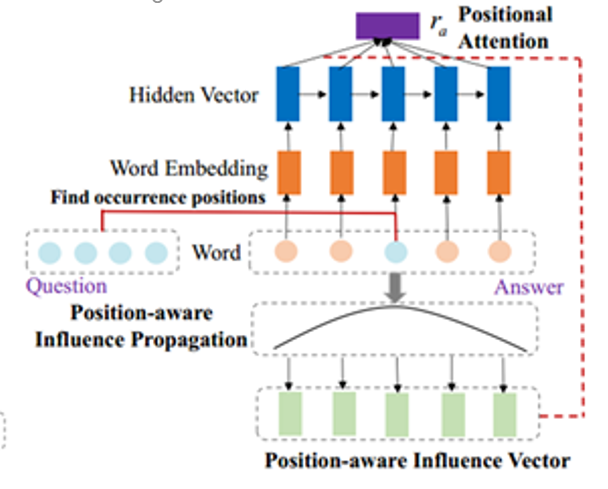

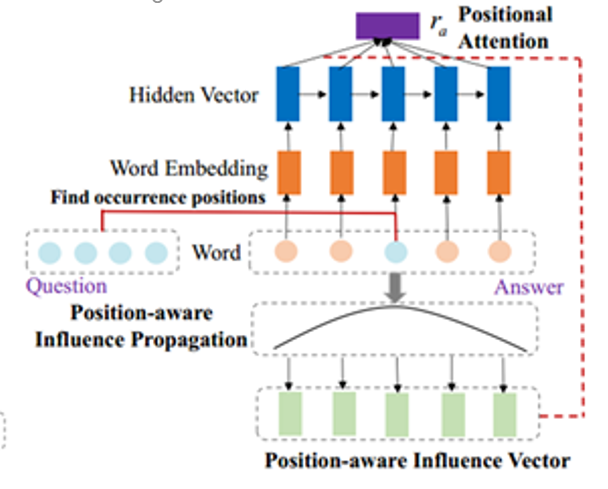

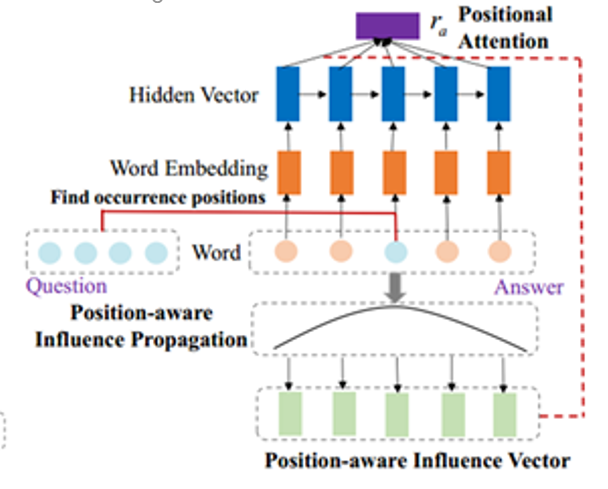

图8.18 用基于位置的RNN回答表示(Chen et al., 2017)

图8.18 用基于位置的RNN回答表示(Chen et al., 2017)

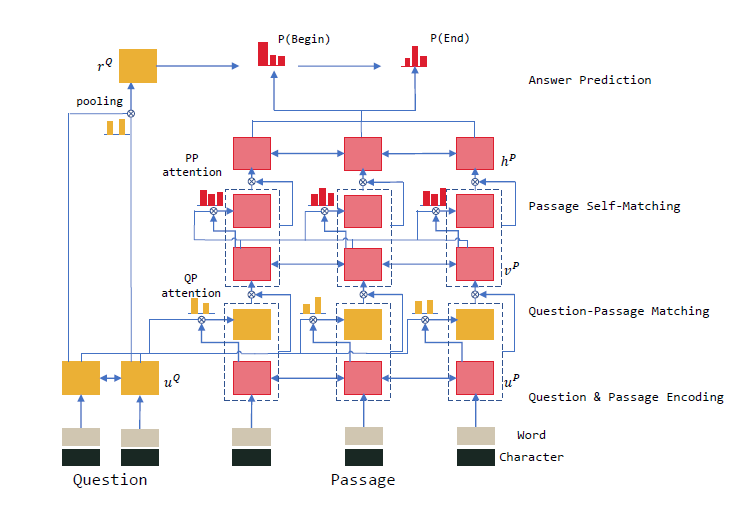

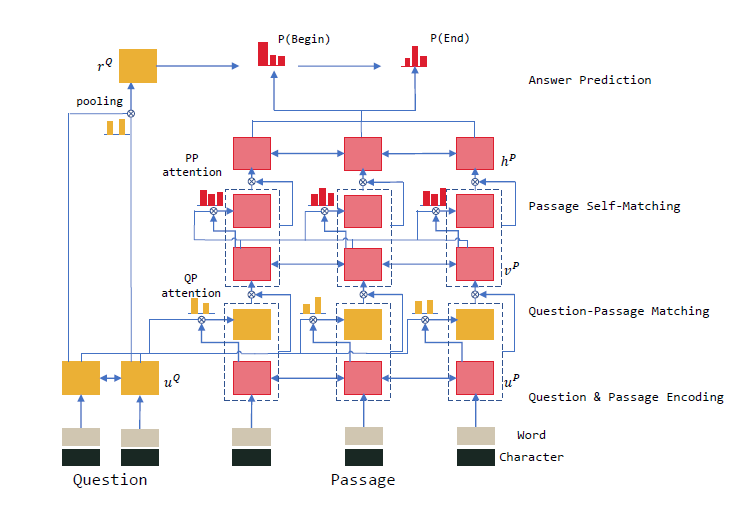

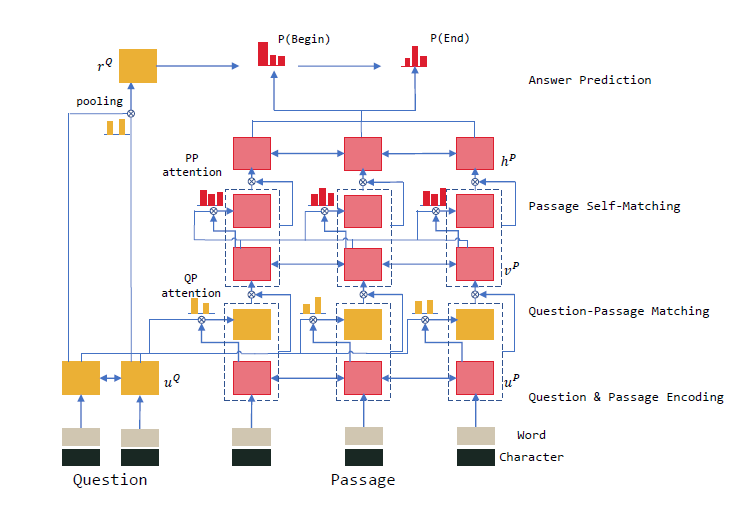

图8.21 R-net 结构图解(Microsoft Asia Natural Language Computing Group, 2017)

图8.21 R-net 结构图解(Microsoft Asia Natural Language Computing Group, 2017)

图8.23 (a)是原始的seq2seq模型,(b)是长度为3的目标端瞥见模型 ,符号“<”和“>”是序列的开始和结束(Shao et al., 2017)

图8.23 (a)是原始的seq2seq模型,(b)是长度为3的目标端瞥见模型 ,符号“<”和“>”是序列的开始和结束(Shao et al., 2017)

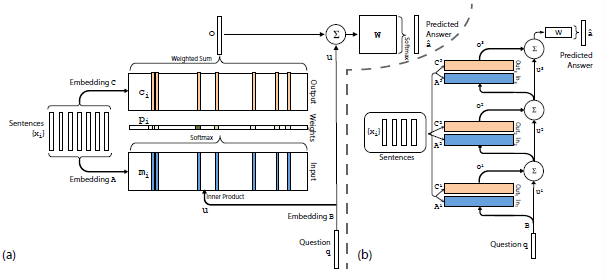

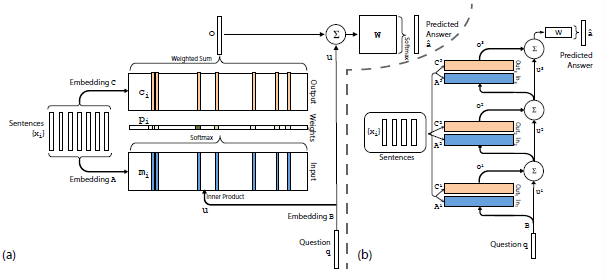

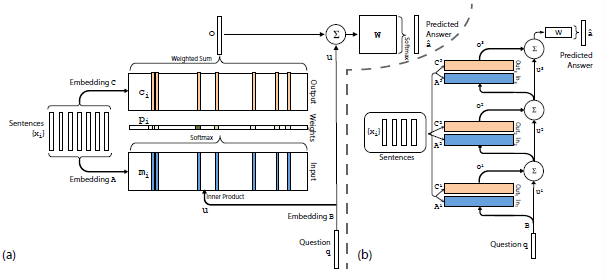

图8.29 (a)模型的单层版本,(b)模型的三层版本(Sukhbaatar et al., 2015)

图8.29 (a)模型的单层版本,(b)模型的三层版本(Sukhbaatar et al., 2015)

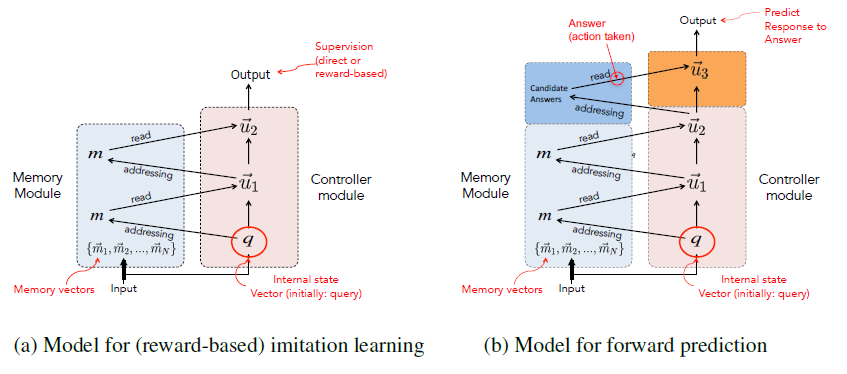

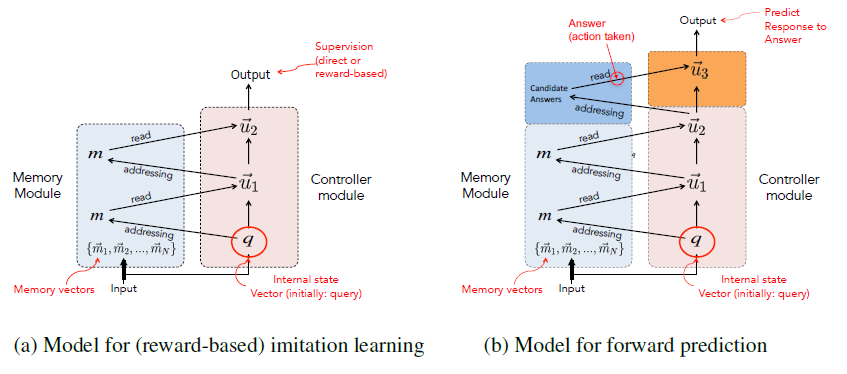

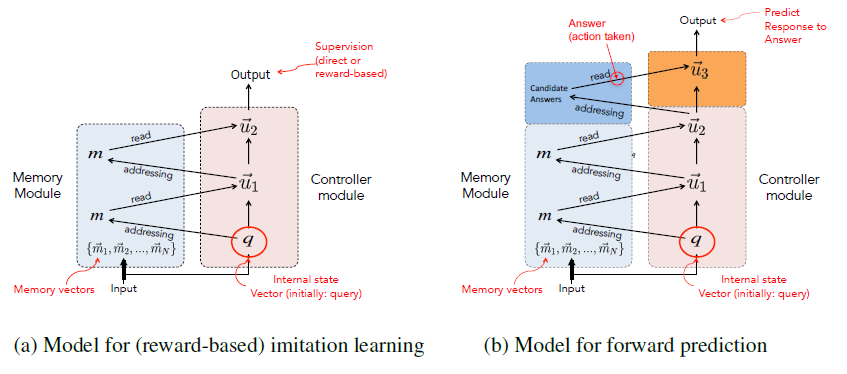

图8.35 (a)基于奖励的模仿学习模型,(b)前馈预测模型(Weston, 2016)

图8.35 (a)基于奖励的模仿学习模型,(b)前馈预测模型(Weston, 2016)

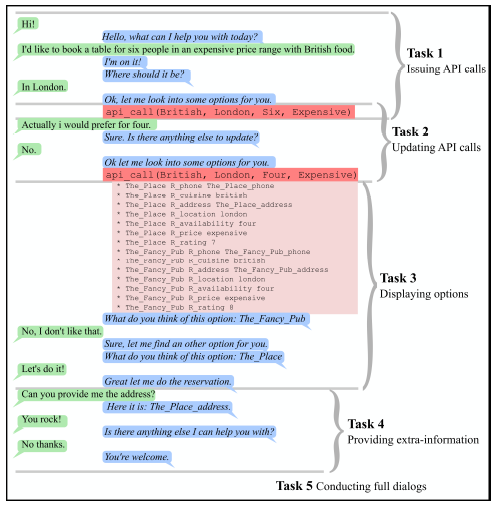

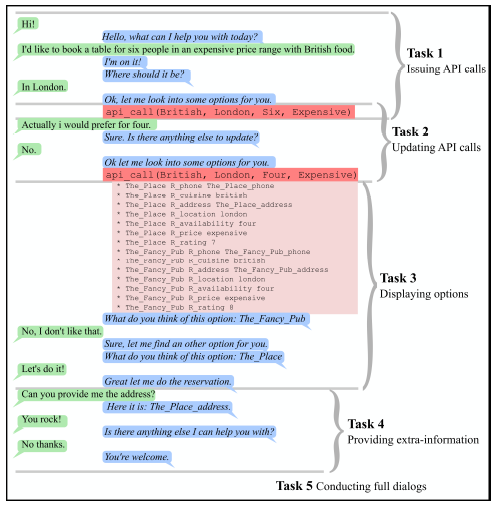

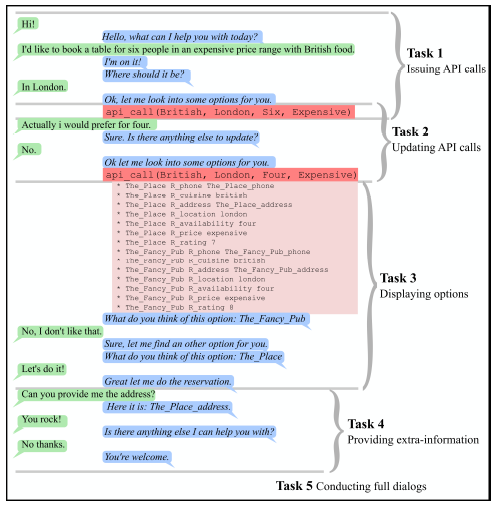

图8.36 面向目标的对话的任务例子(Bordes et al., 2016)

图8.36 面向目标的对话的任务例子(Bordes et al., 2016)