图16.1 根据L-BFGS方法在AlexNet上产生的6组对抗样本

图16.1 根据L-BFGS方法在AlexNet上产生的6组对抗样本

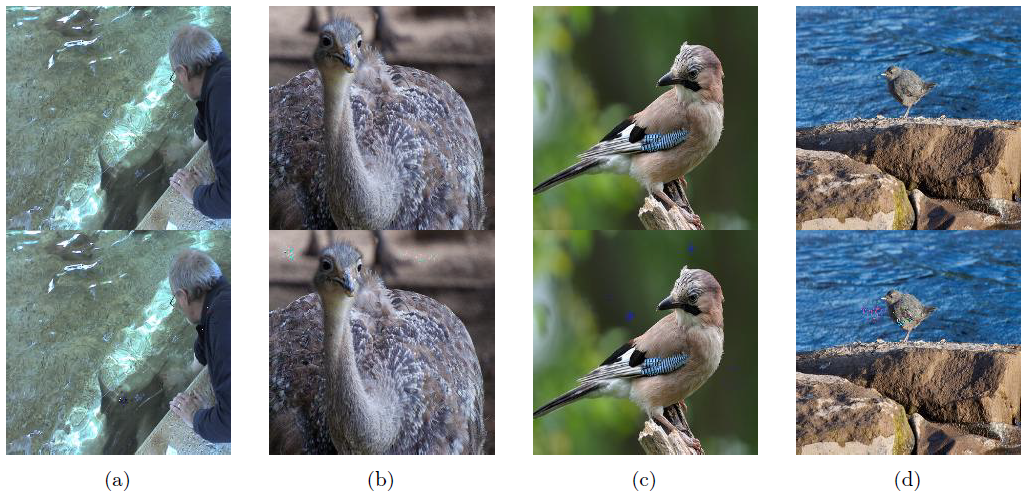

图16.2 修改了一个像素的图片

图16.2 修改了一个像素的图片

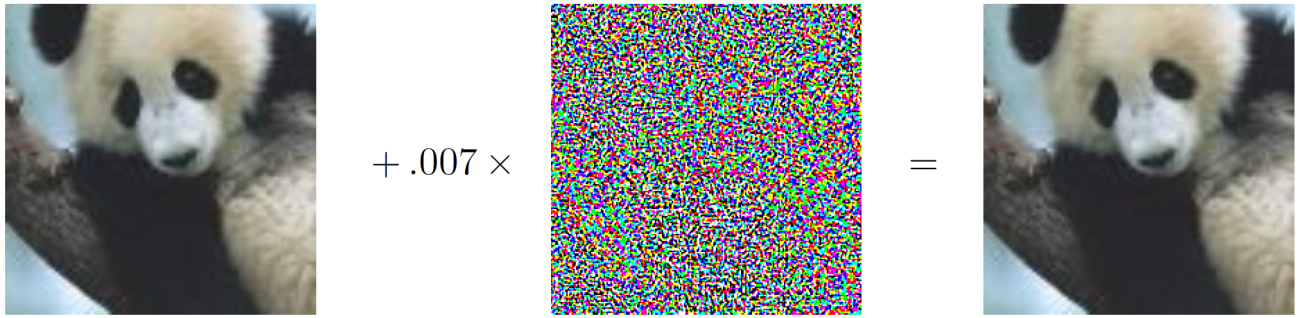

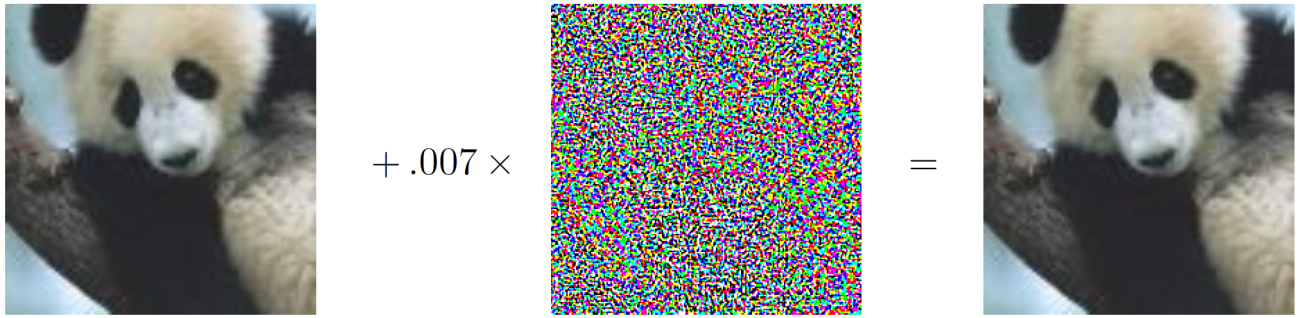

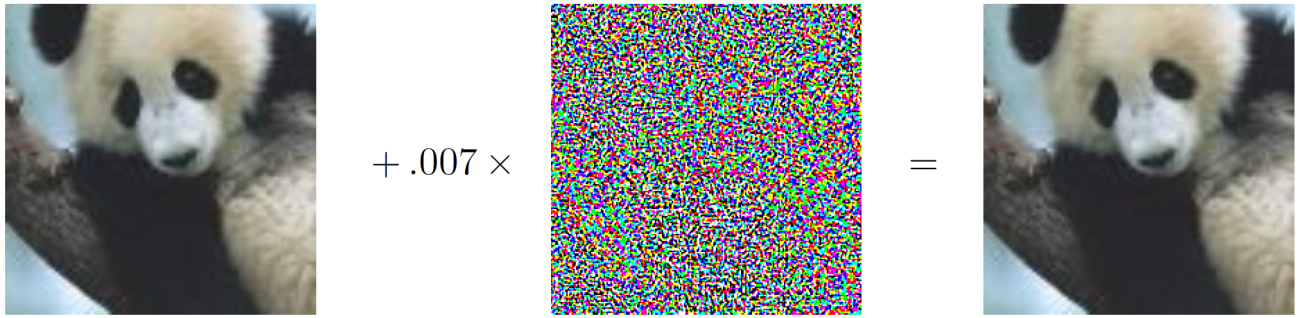

图16.3 FGSM方法产生对抗样本示例

图16.3 FGSM方法产生对抗样本示例

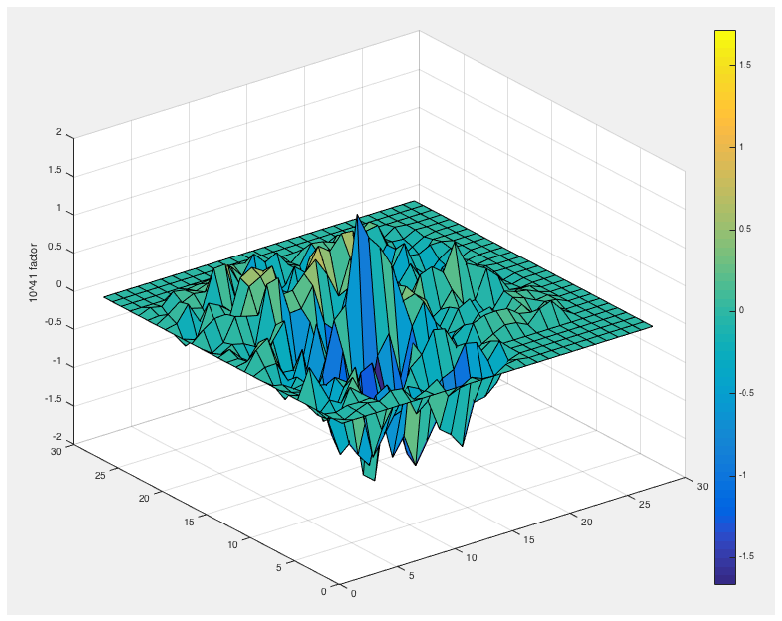

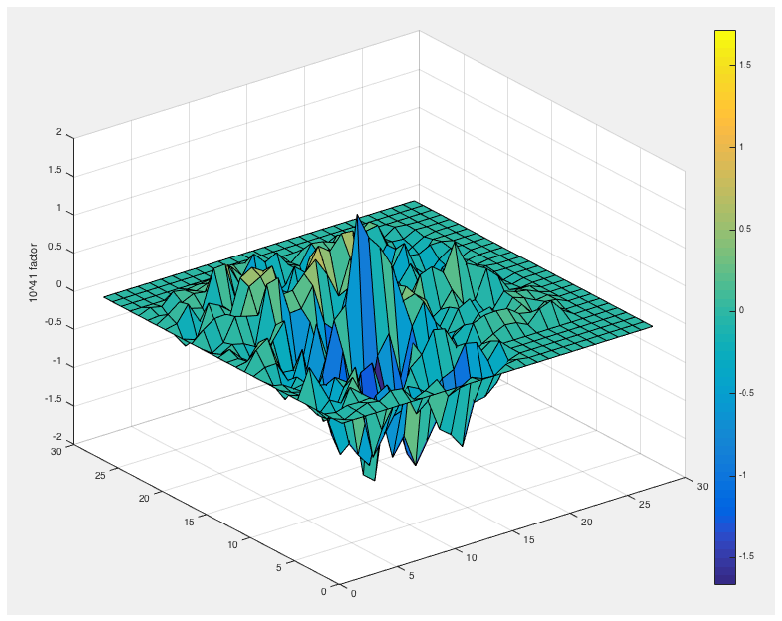

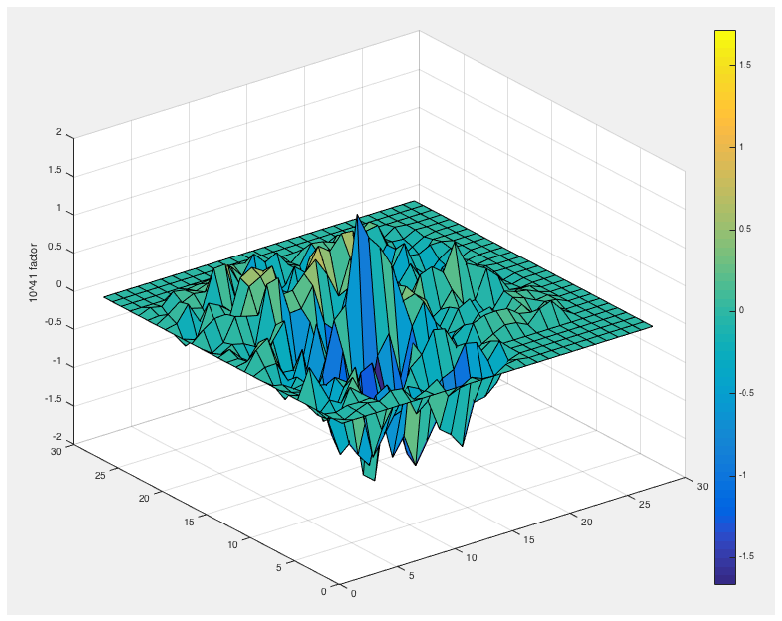

图16.4 LeNet架构下784维输入的显著图,784维输入对应28*28的图片像素

图16.4 LeNet架构下784维输入的显著图,784维输入对应28*28的图片像素

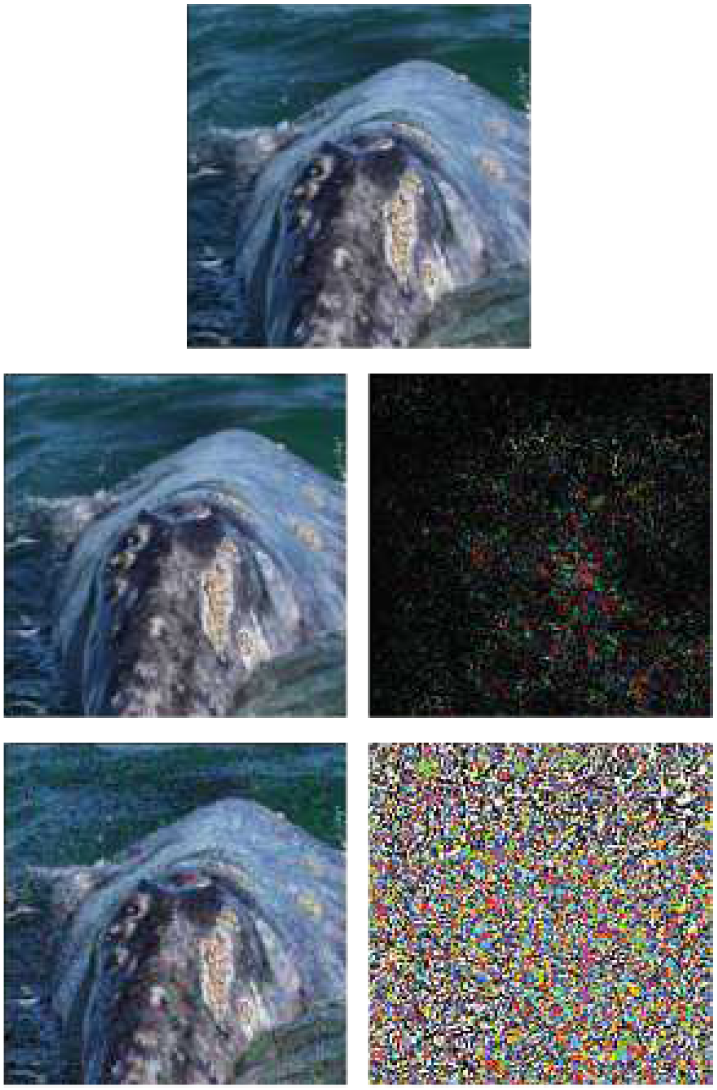

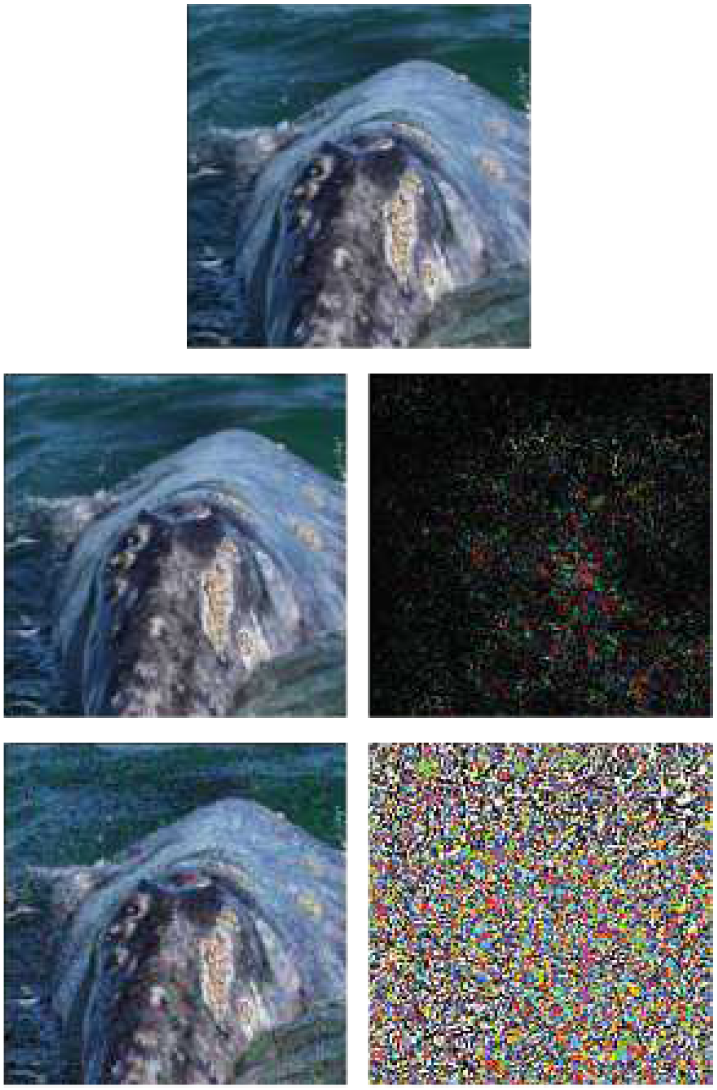

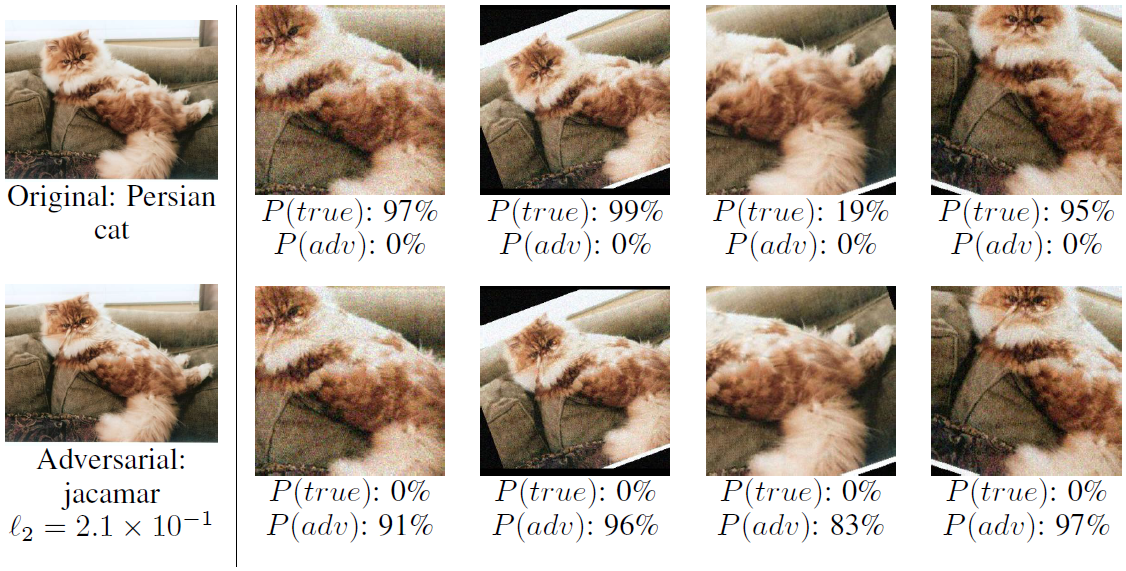

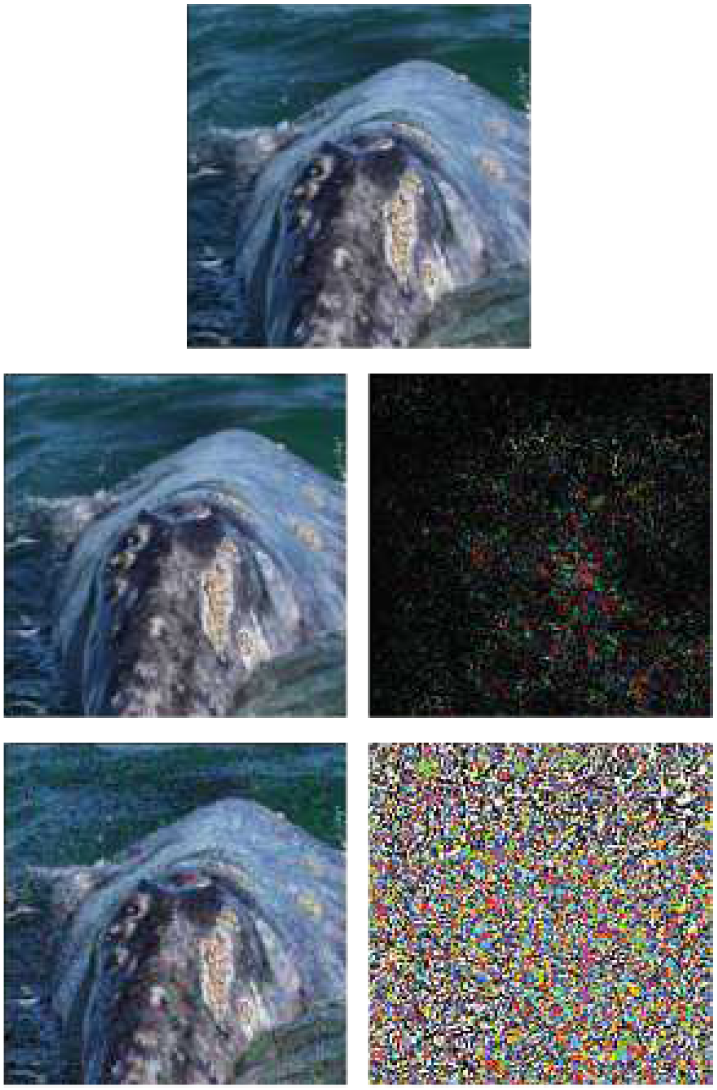

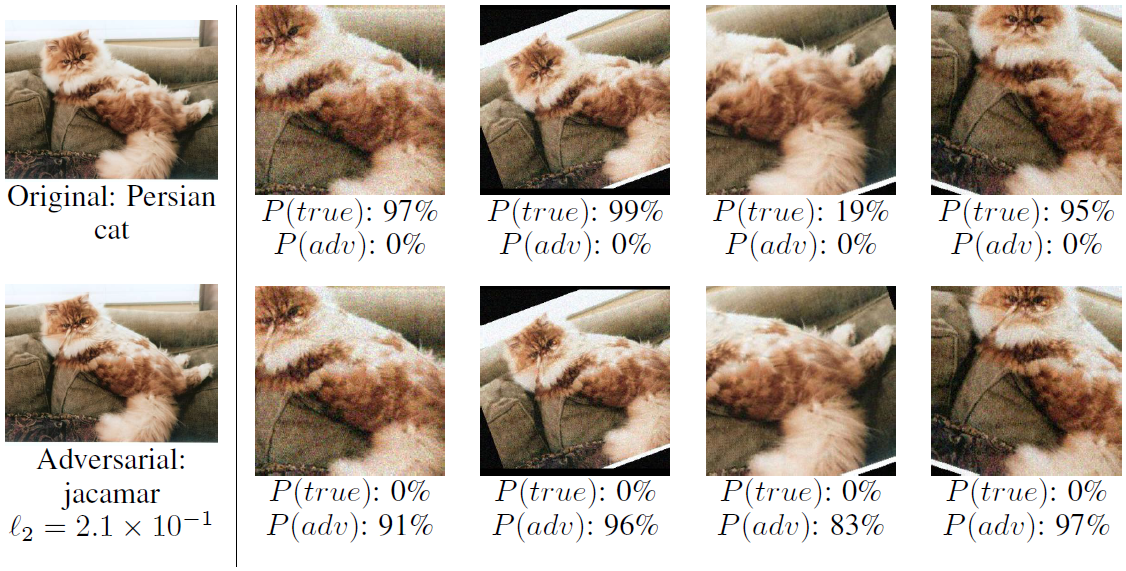

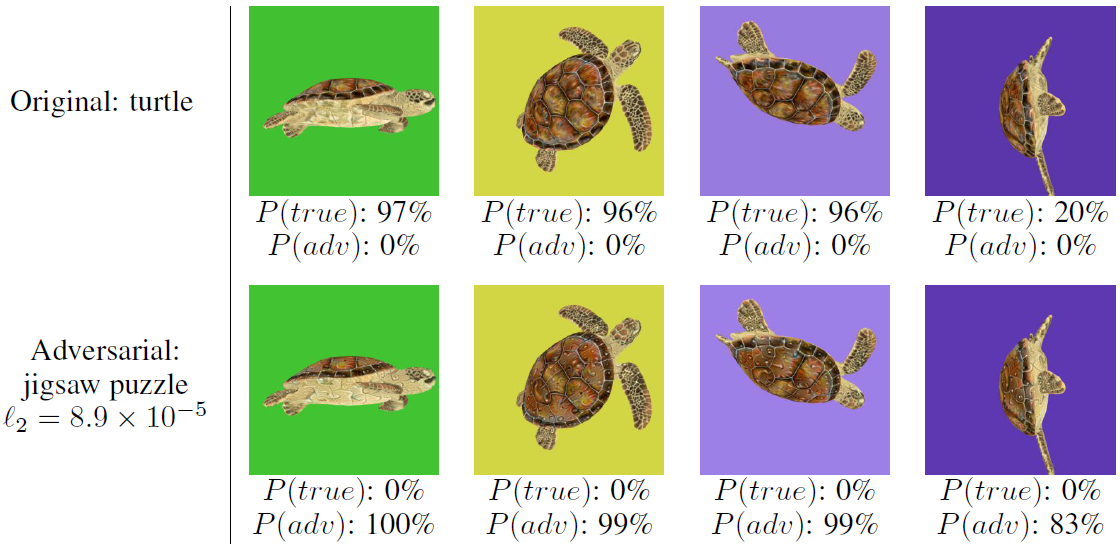

图16.5 DeepFool和FGSM产生的对抗样本对比,第一行是原始图片,类别为鲸鱼,第二行是DeepFool产生的对抗样本及其扰动,第三行是FGSM产生的对抗样本及其扰动

图16.5 DeepFool和FGSM产生的对抗样本对比,第一行是原始图片,类别为鲸鱼,第二行是DeepFool产生的对抗样本及其扰动,第三行是FGSM产生的对抗样本及其扰动

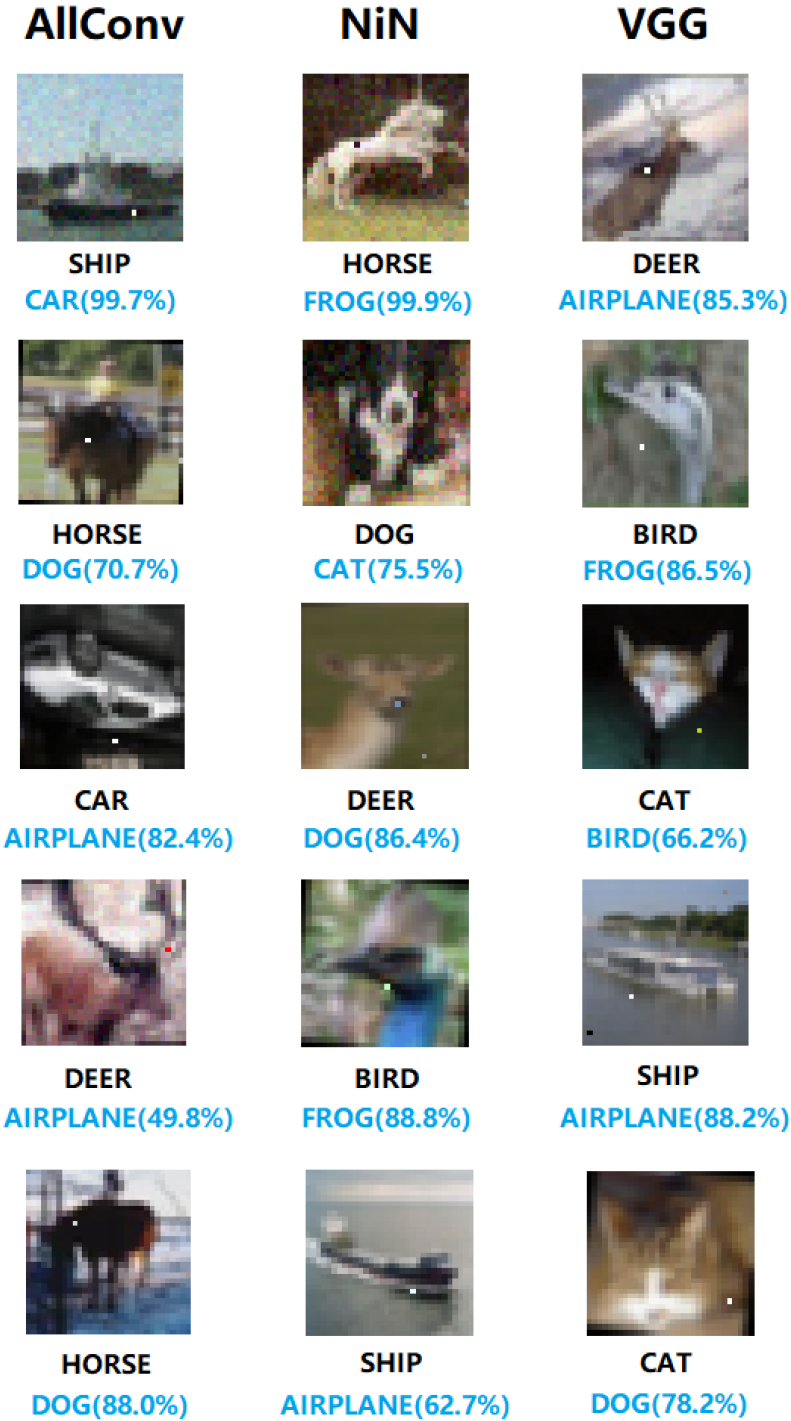

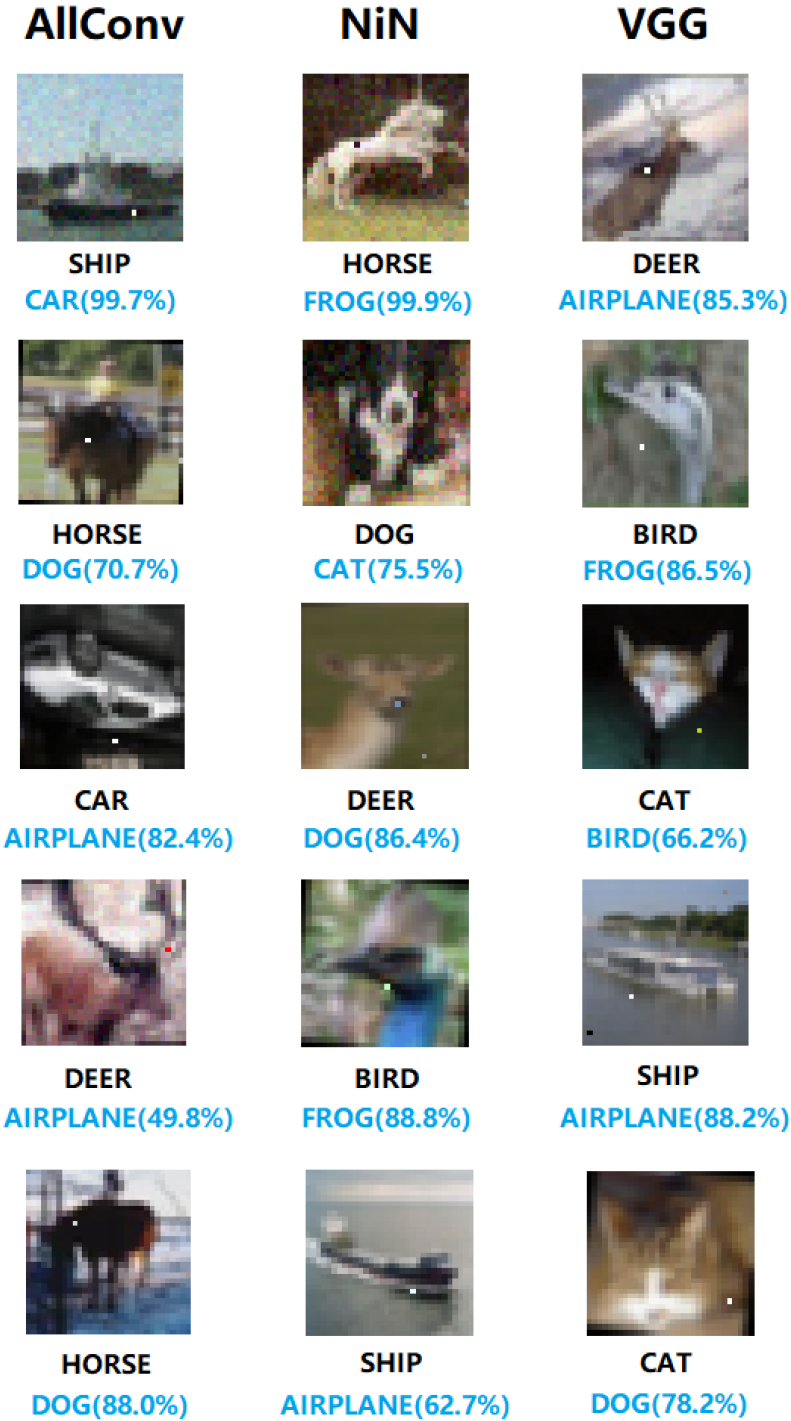

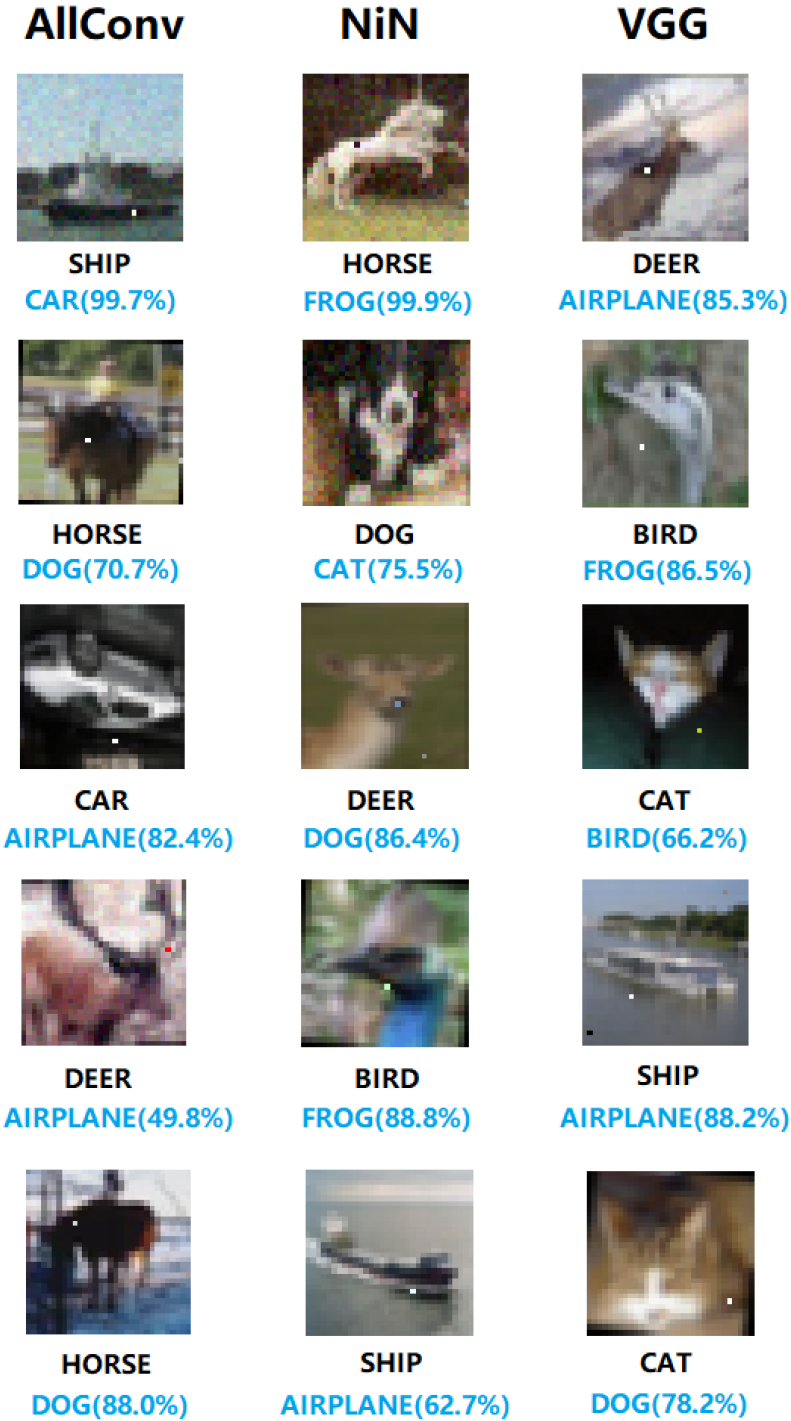

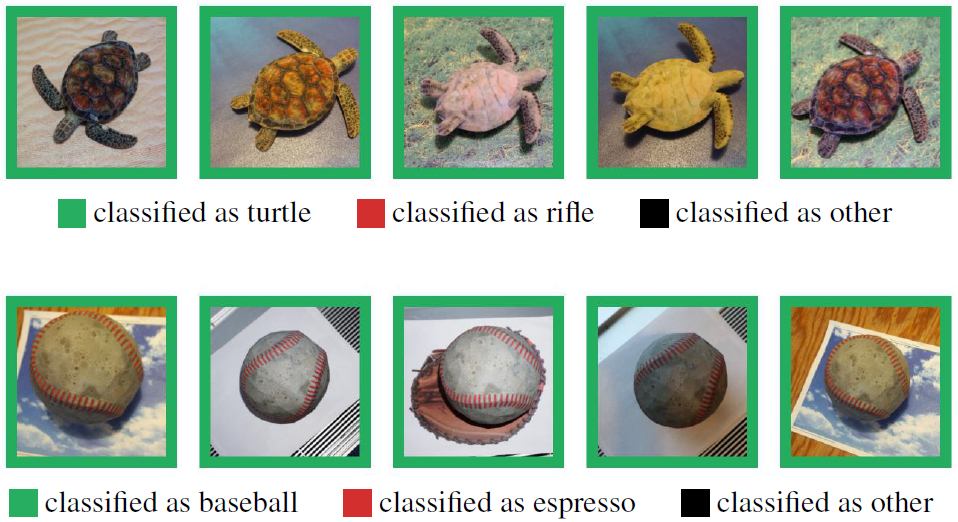

图16.6 CIFAR-10数据集上的单像素攻击,使用了三种网络

图16.6 CIFAR-10数据集上的单像素攻击,使用了三种网络

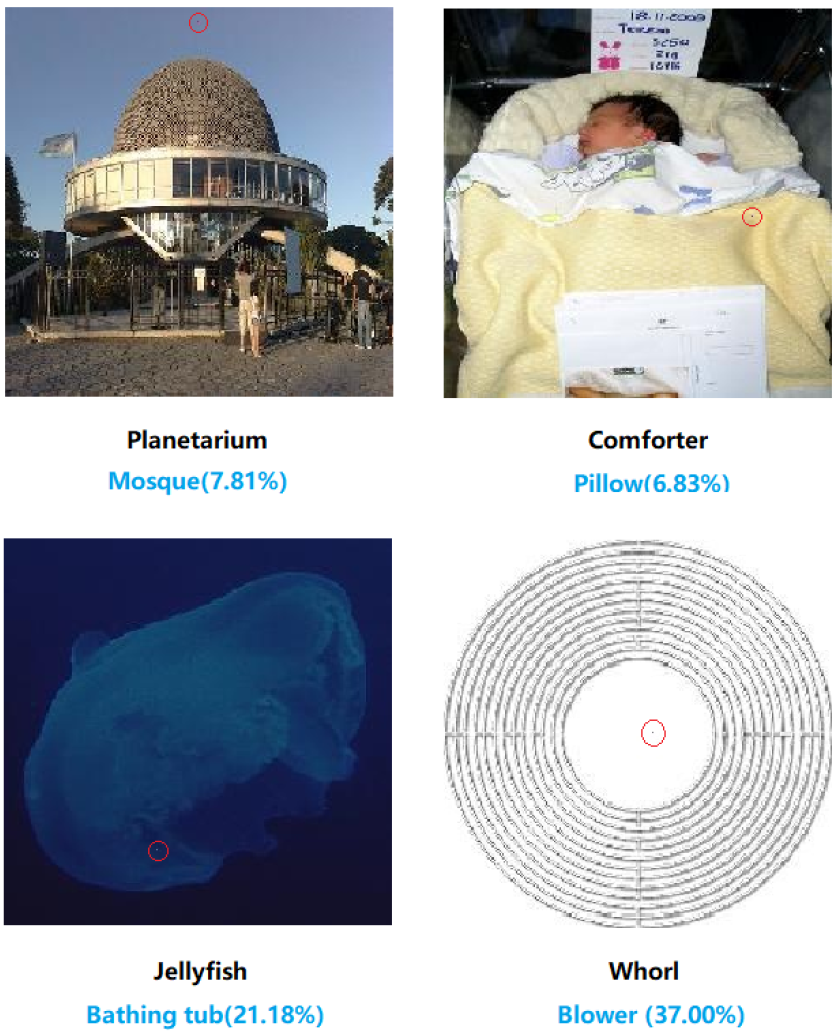

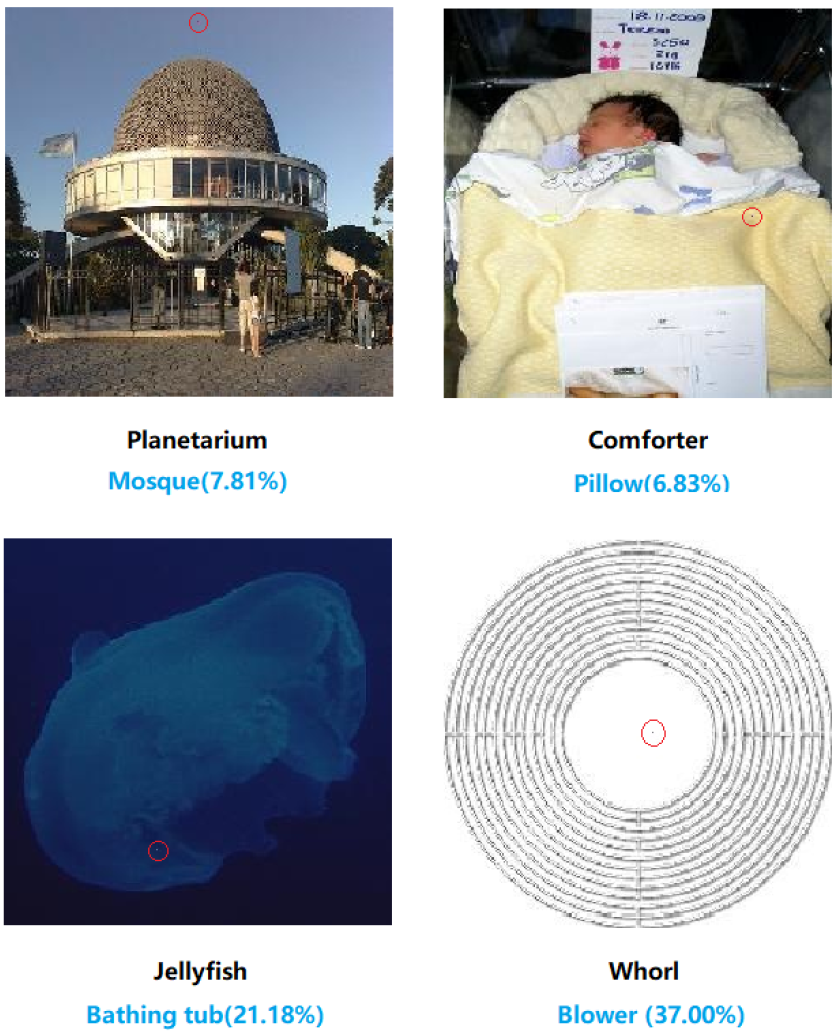

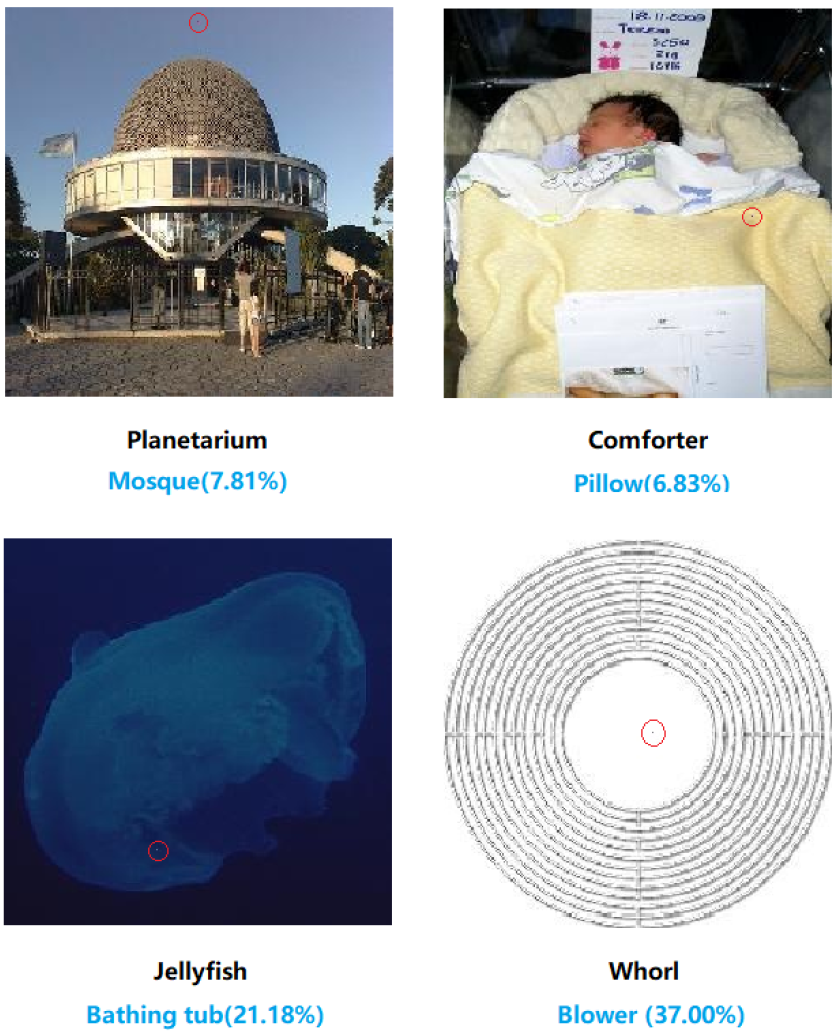

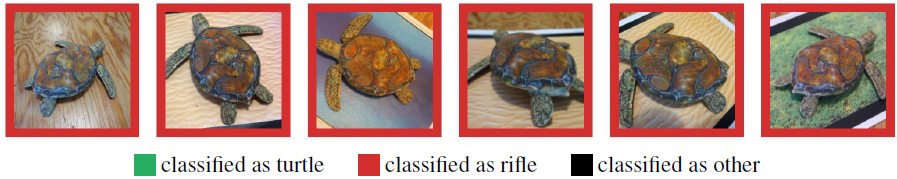

图16.7 ImageNet数据集上的单像素攻击,被修改的像素以红圈标识

图16.7 ImageNet数据集上的单像素攻击,被修改的像素以红圈标识

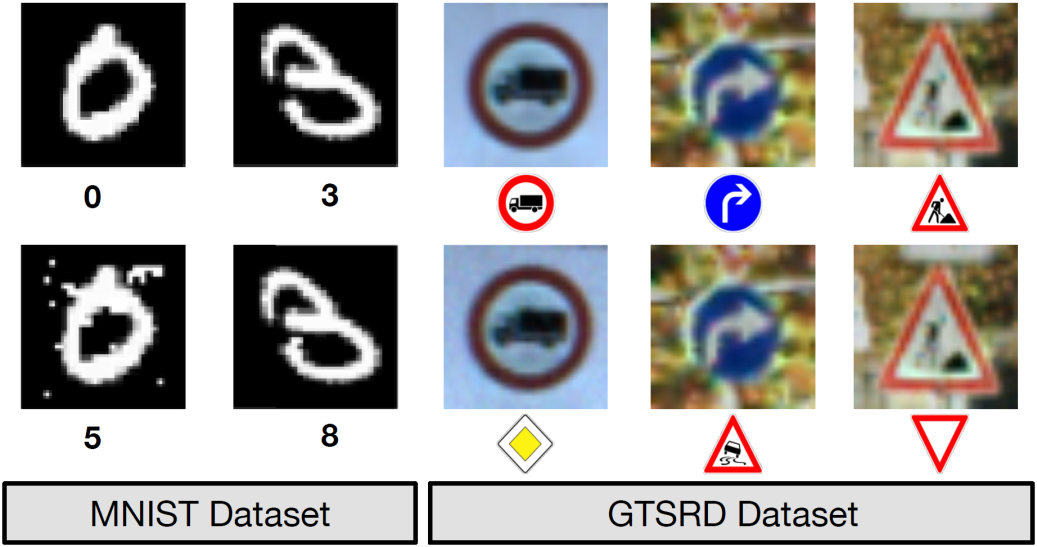

图16.9 黑盒攻击产生的对抗样本

图16.9 黑盒攻击产生的对抗样本

图16.10 局部搜索对抗算法产生的对抗样本

图16.10 局部搜索对抗算法产生的对抗样本

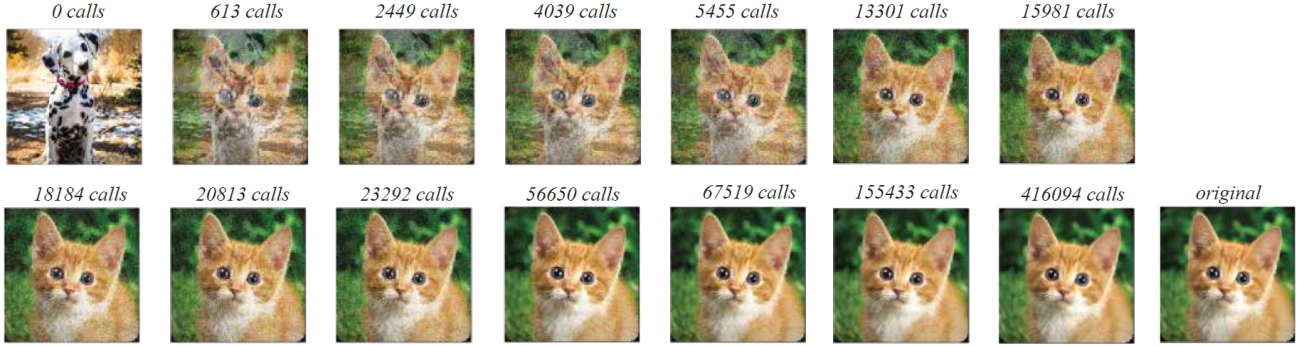

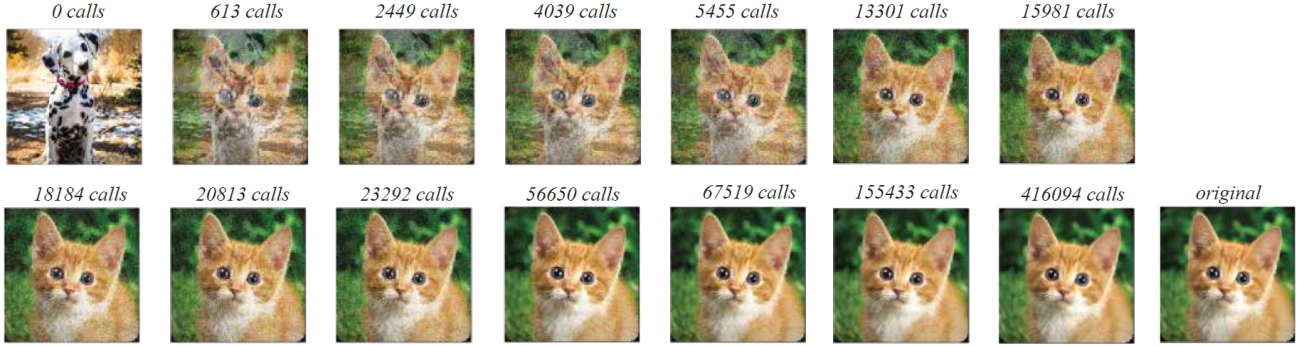

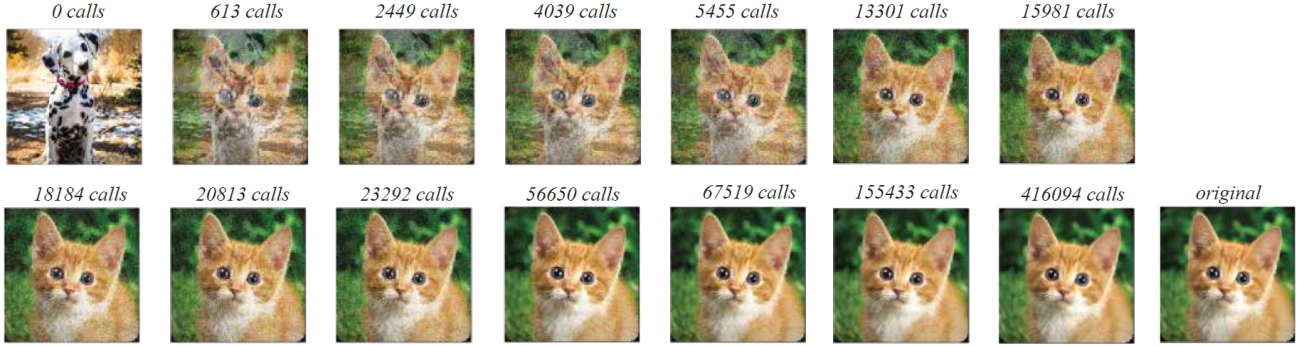

图16.11 边界攻击的有目标攻击过程

图16.11 边界攻击的有目标攻击过程

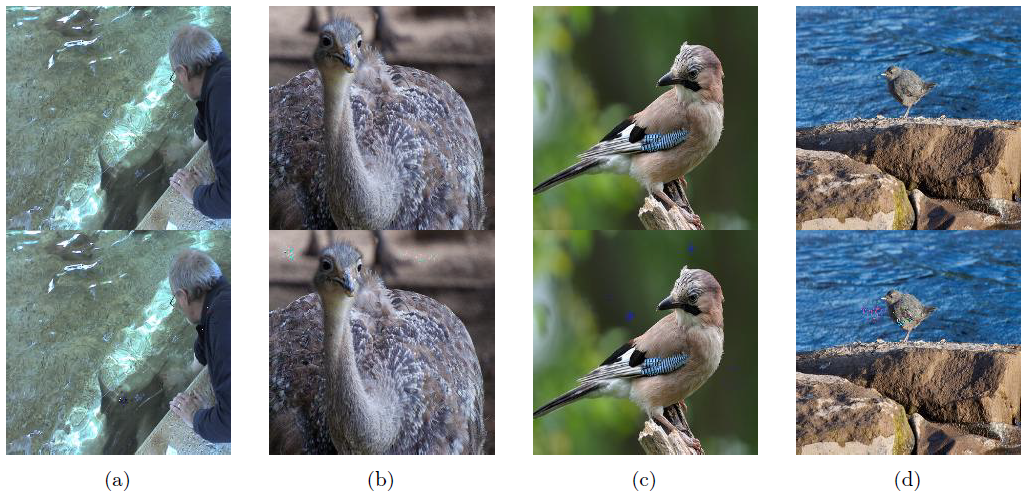

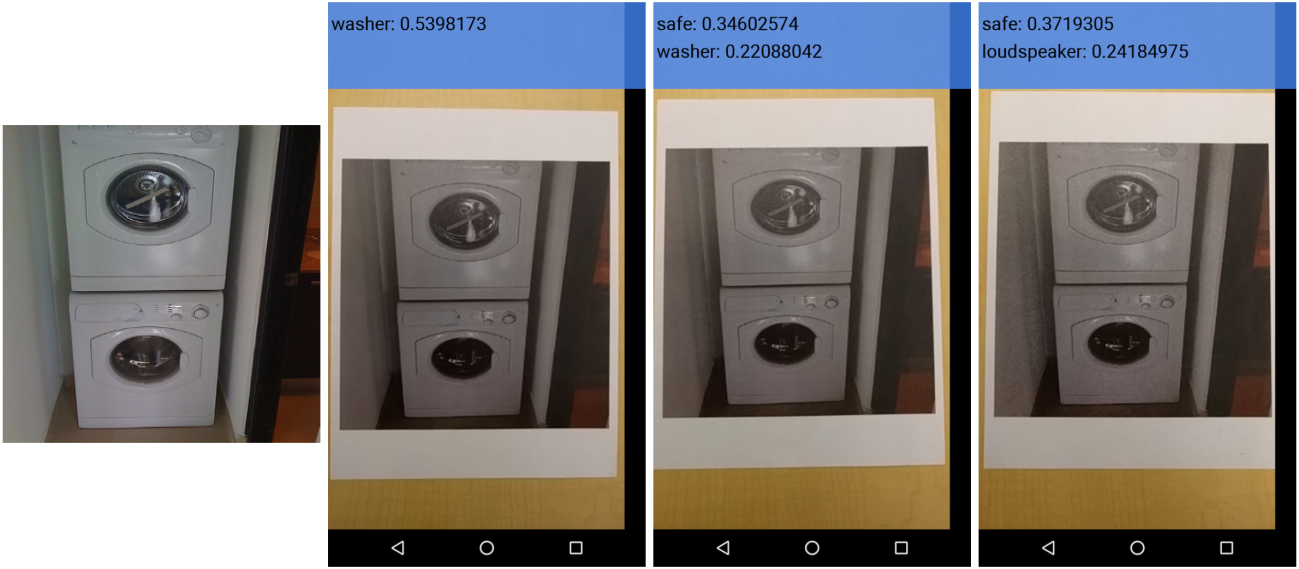

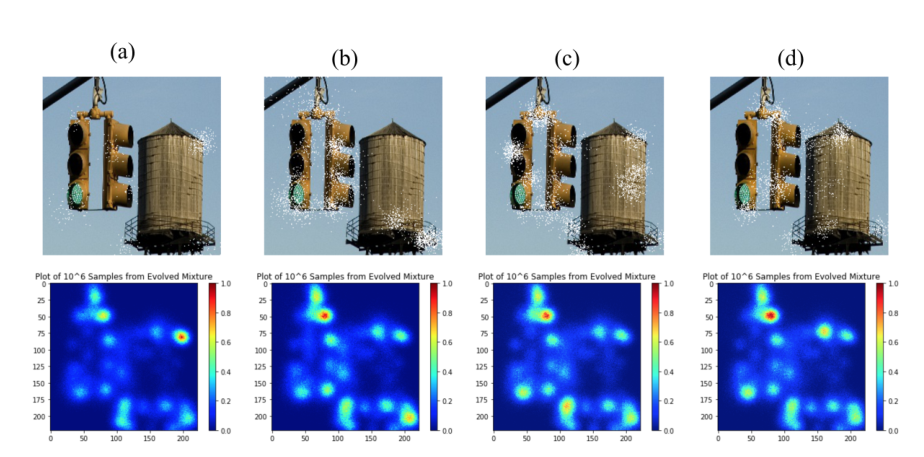

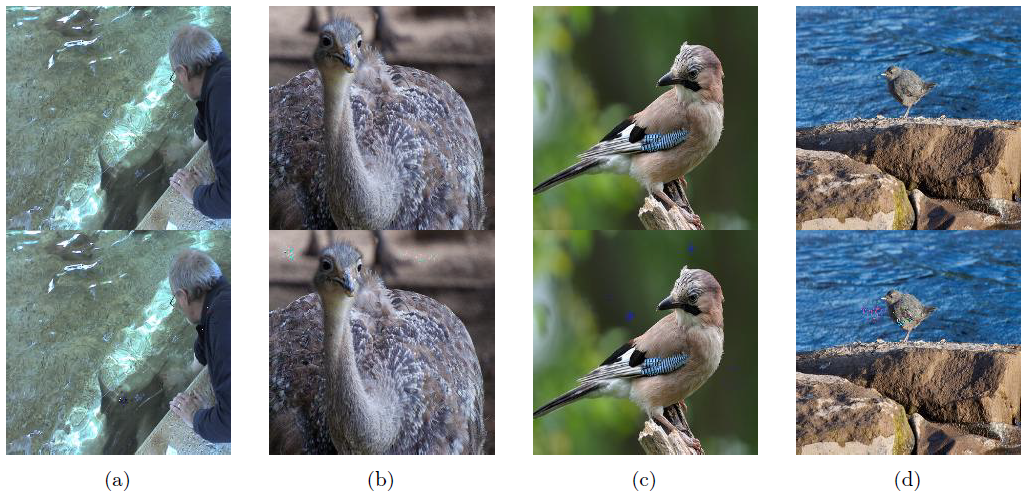

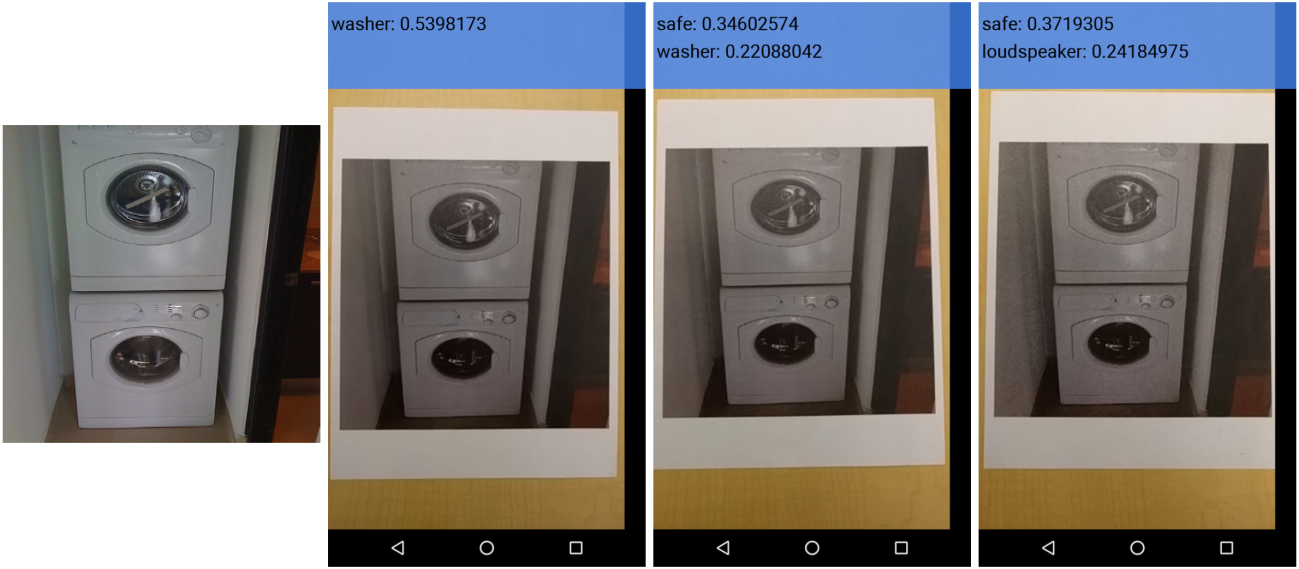

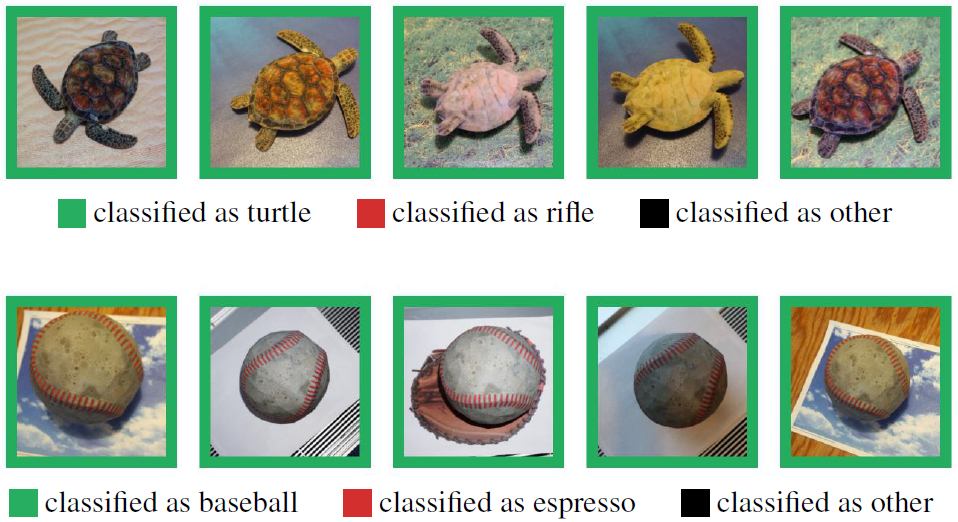

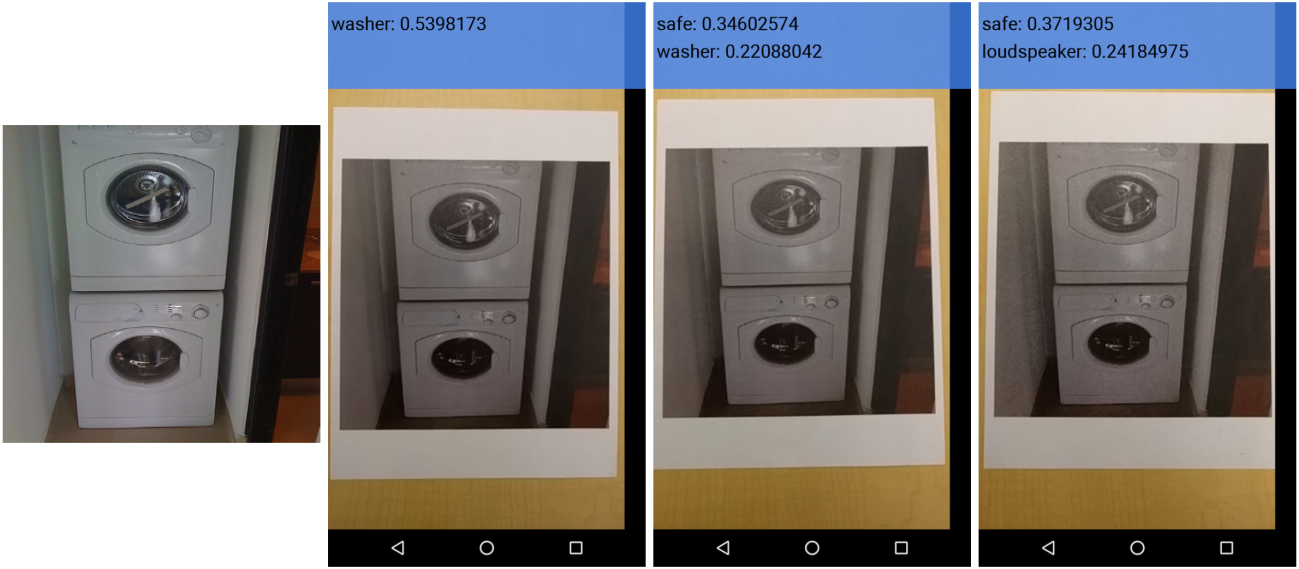

图16.13 现实世界的对抗样本攻击。使用摄像头获取打印出的对抗样本进行攻击,左至右依次为原图片,摄像头下的原图片,摄像头下的对抗样本(ϵ=4),摄像头下的对抗样本(ϵ=8)

图16.13 现实世界的对抗样本攻击。使用摄像头获取打印出的对抗样本进行攻击,左至右依次为原图片,摄像头下的原图片,摄像头下的对抗样本(ϵ=4),摄像头下的对抗样本(ϵ=8)

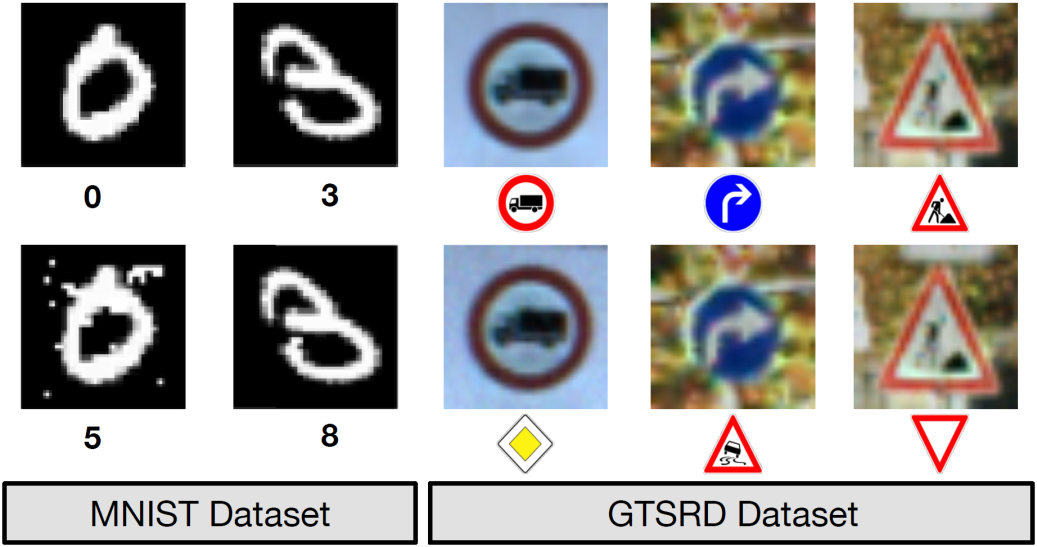

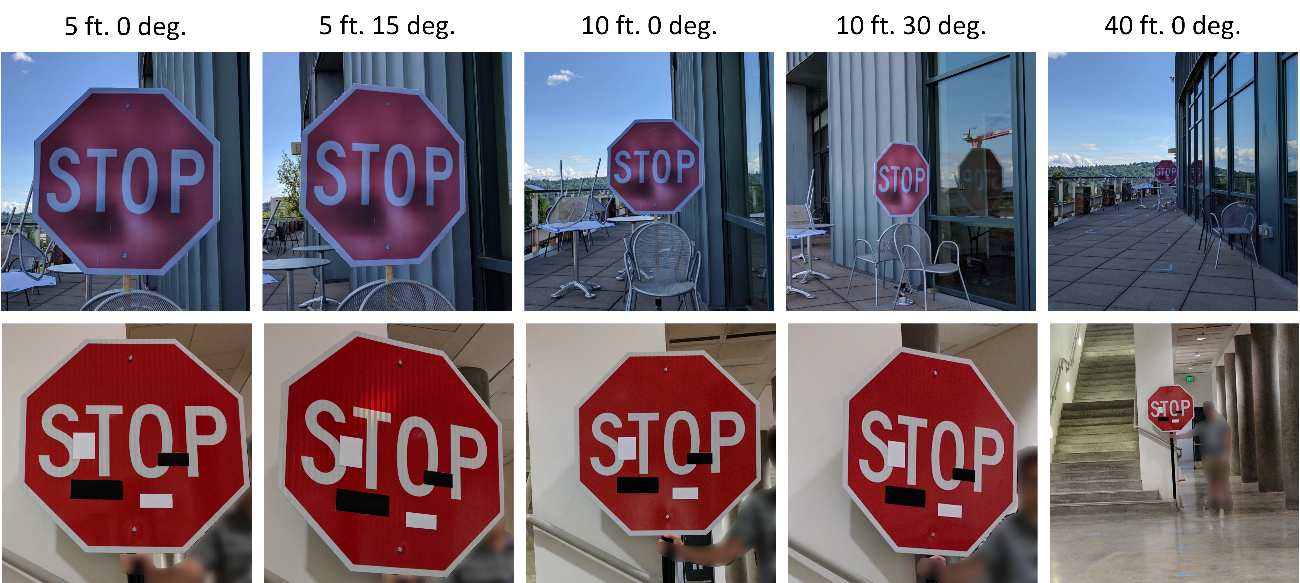

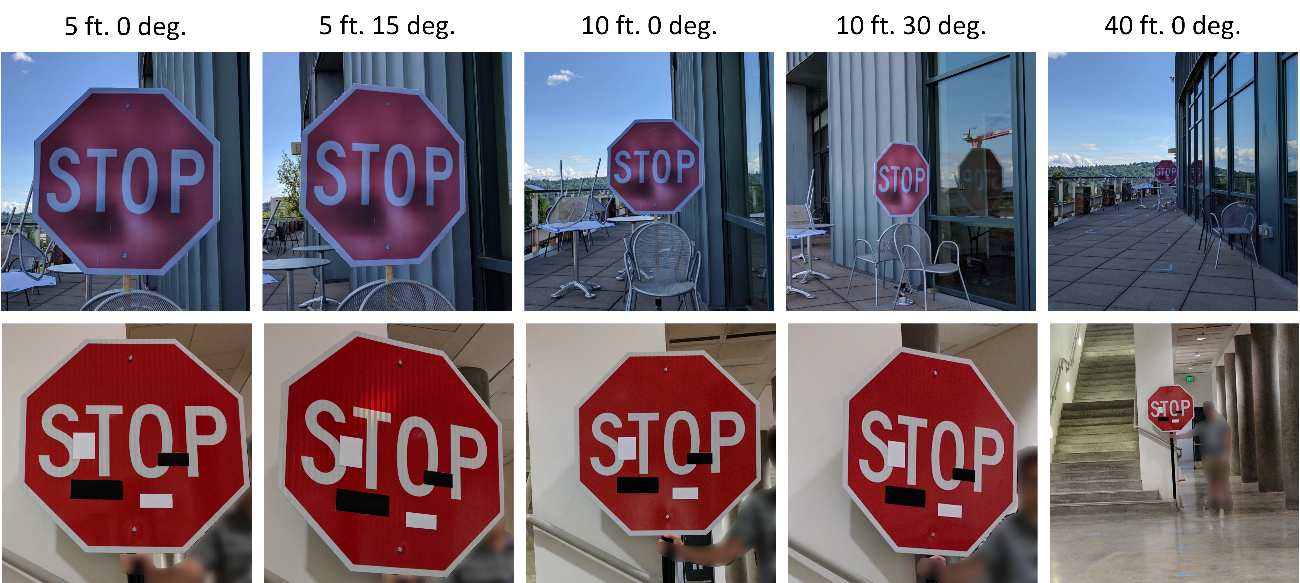

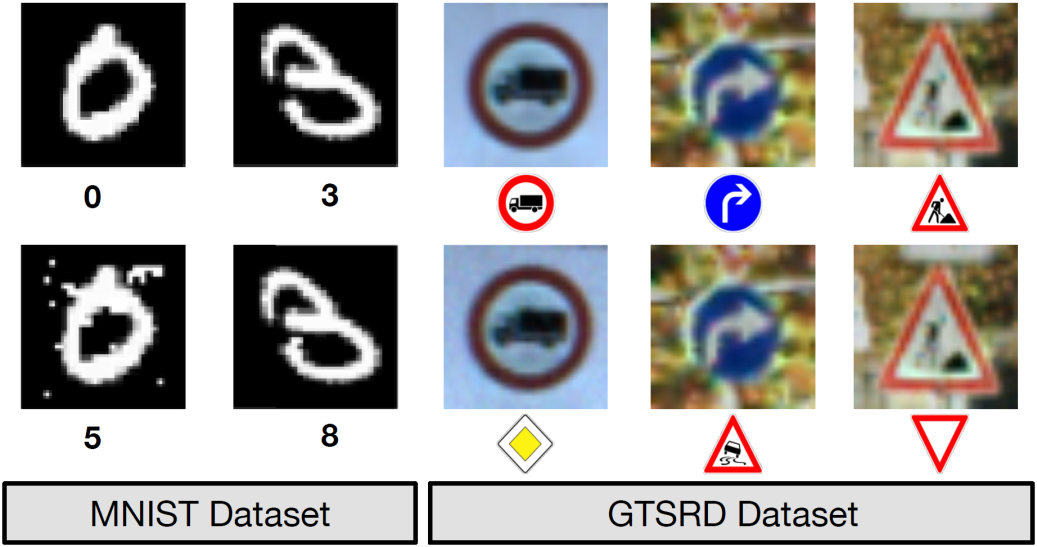

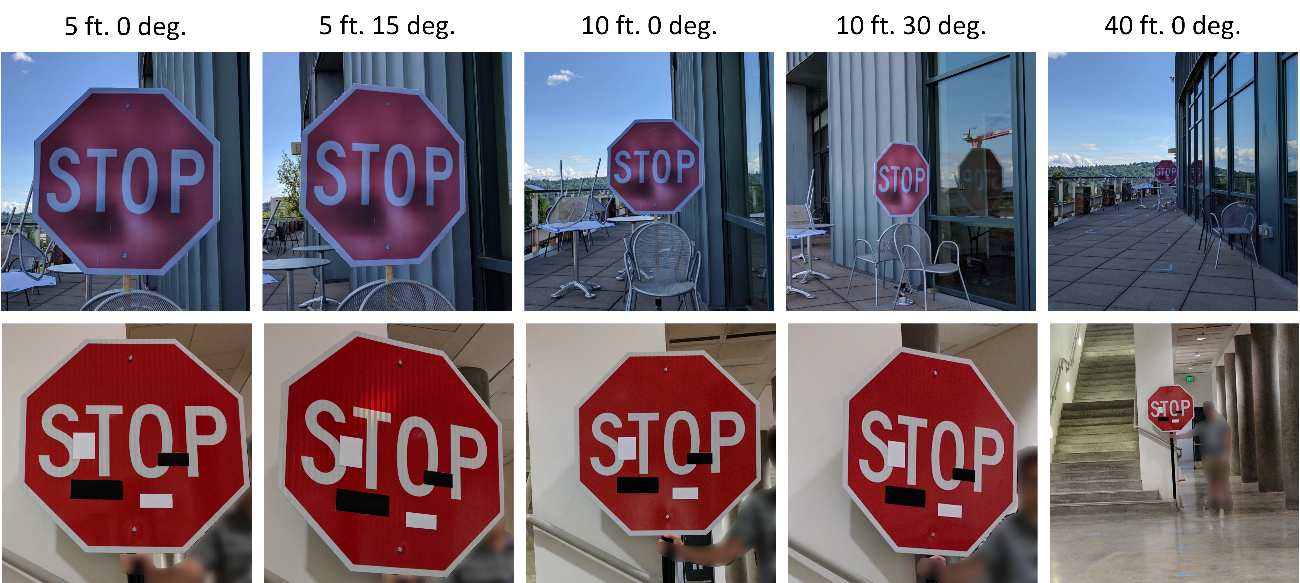

图16.14 道路标志攻击样本。

图16.14 道路标志攻击样本。

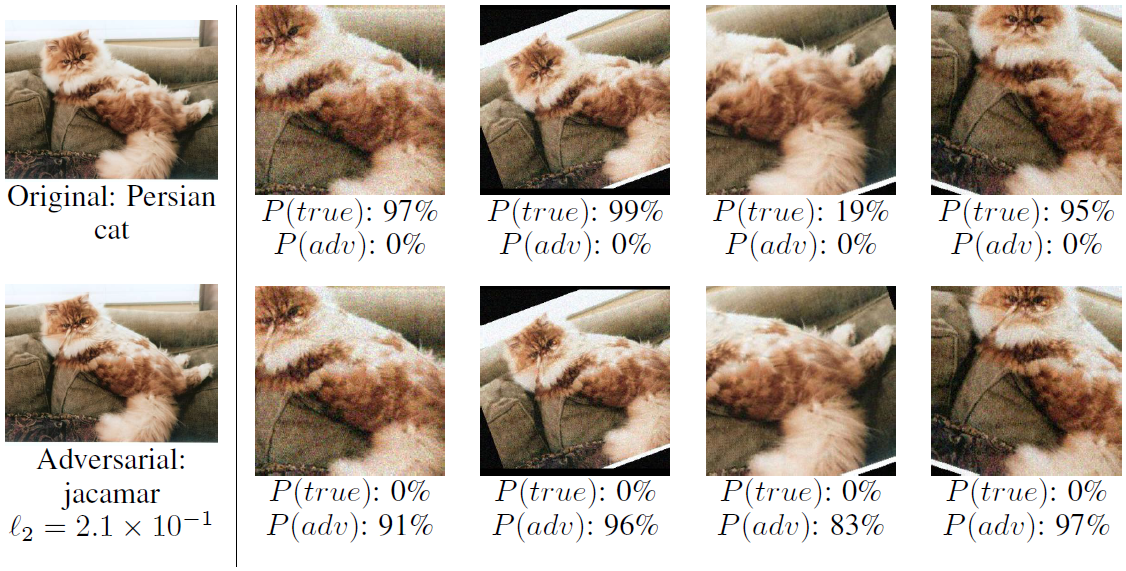

图16.15 2D对抗样本示例

图16.15 2D对抗样本示例

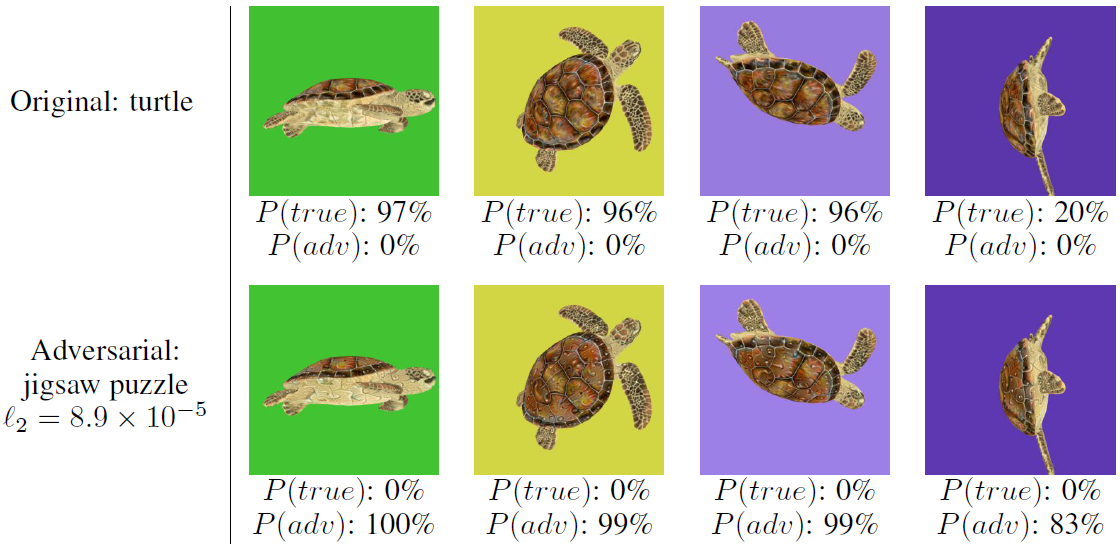

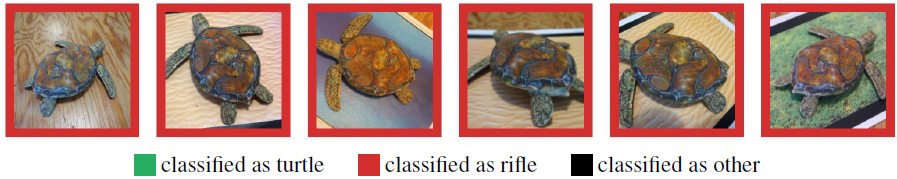

图16.16 3D对抗样本示例

图16.16 3D对抗样本示例

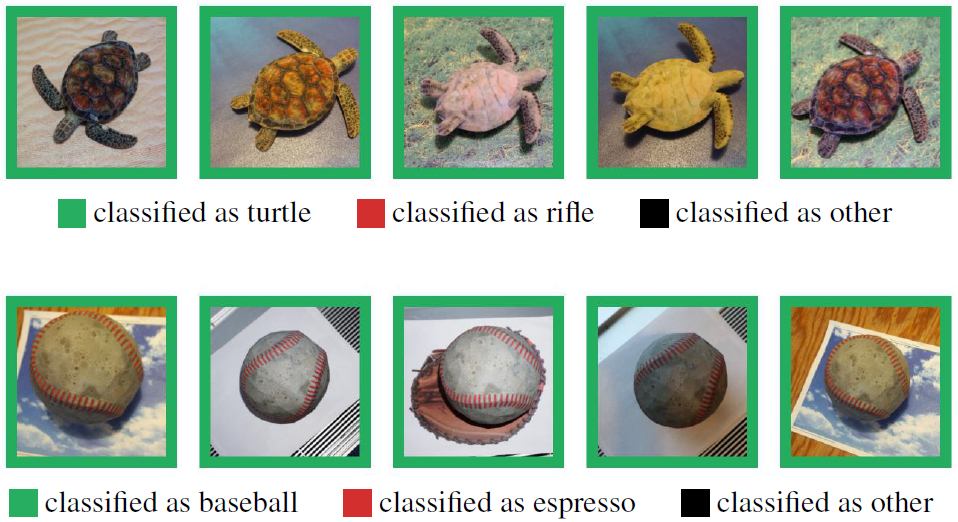

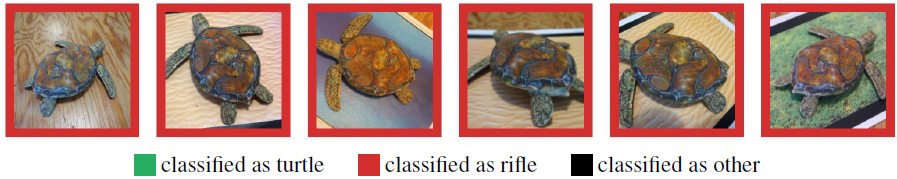

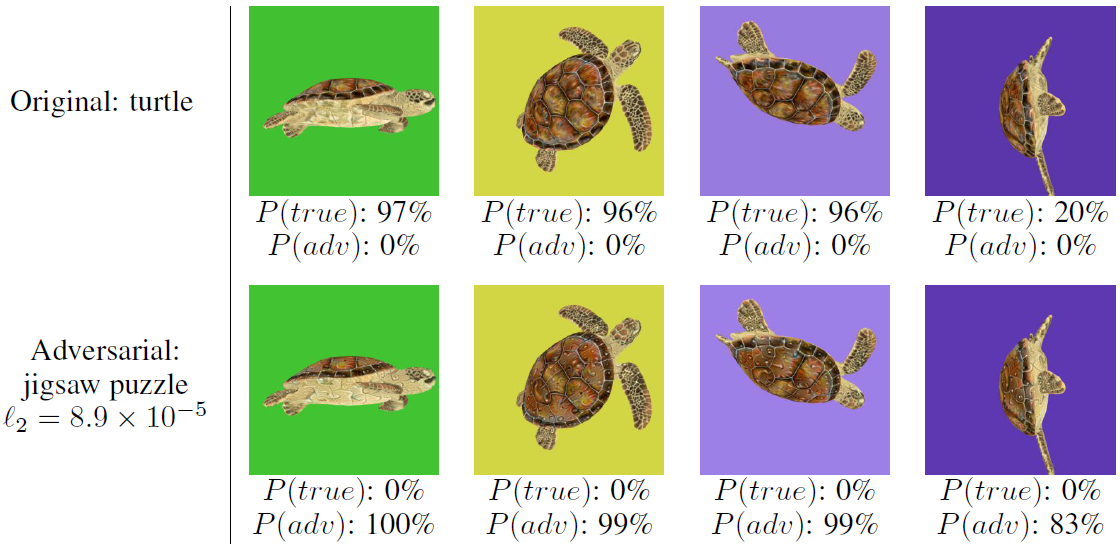

图16.17 物理环境3D对抗样本。第一行和第二行的模型分别是原始样本和对抗样本

图16.17 物理环境3D对抗样本。第一行和第二行的模型分别是原始样本和对抗样本

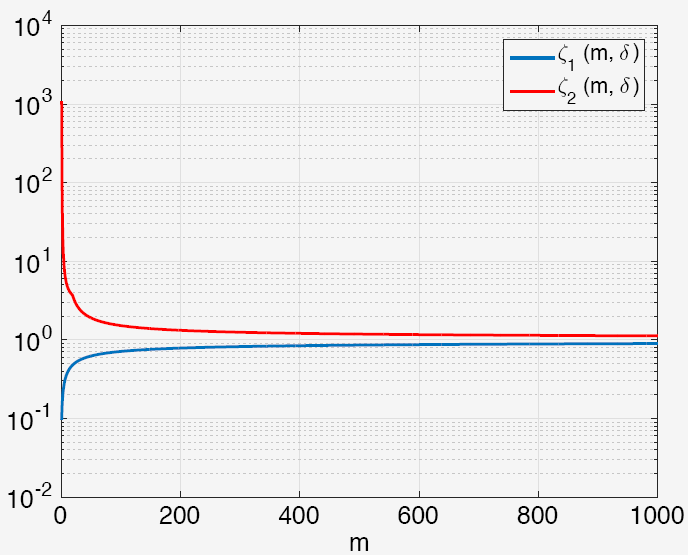

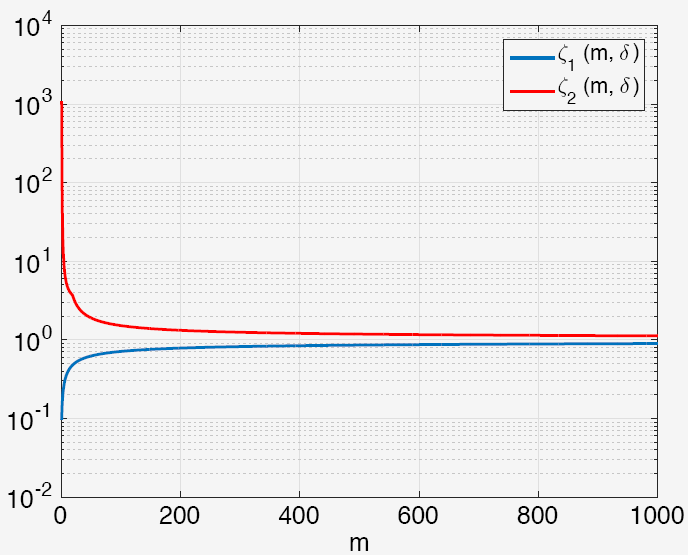

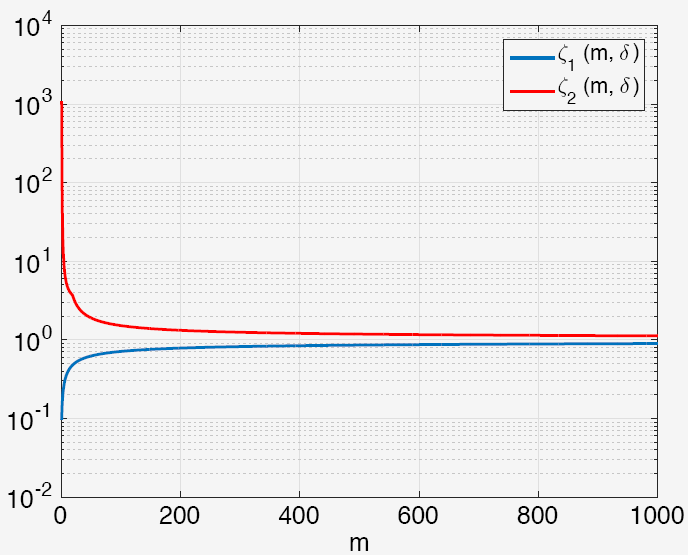

图16.22 ζ_1 (m,δ)和 ζ_2 (m,δ)关于m的函数图

图16.22 ζ_1 (m,δ)和 ζ_2 (m,δ)关于m的函数图

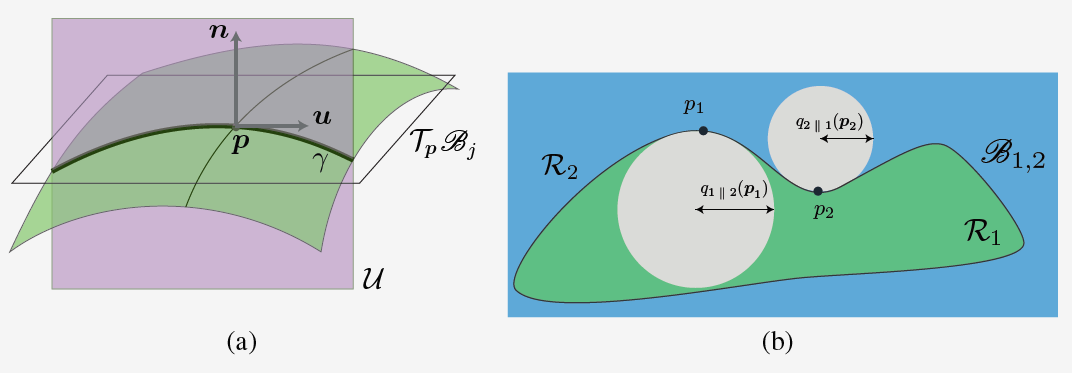

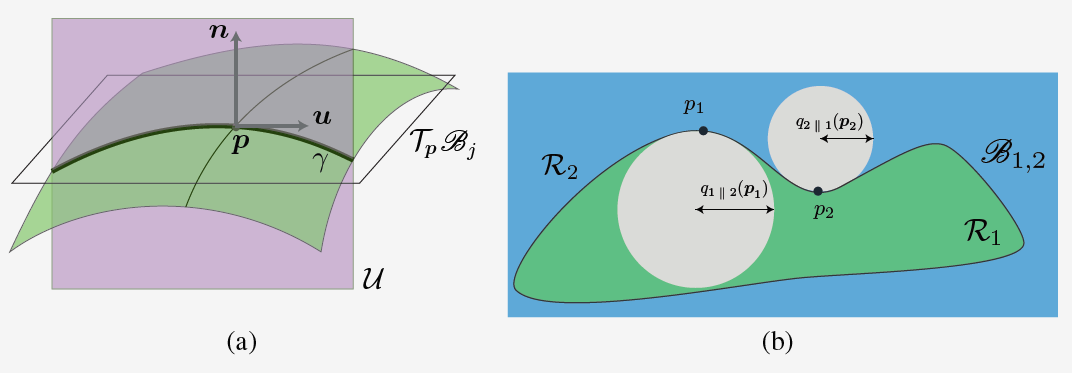

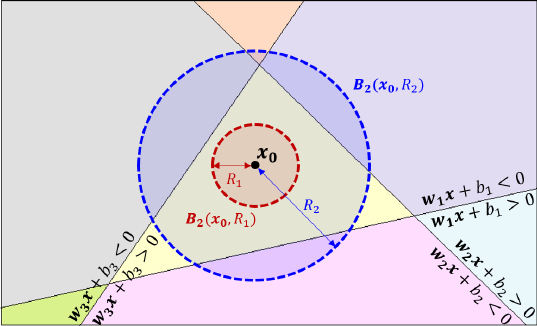

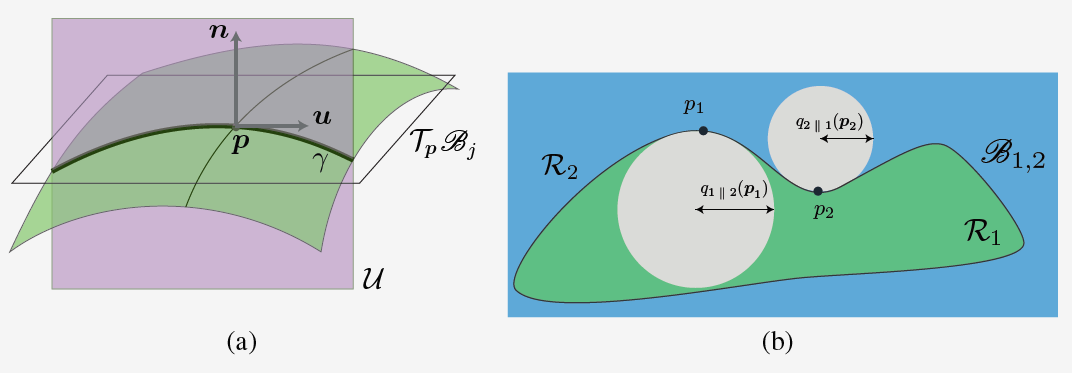

图16.23 正截面图和二维度量图解

图16.23 正截面图和二维度量图解

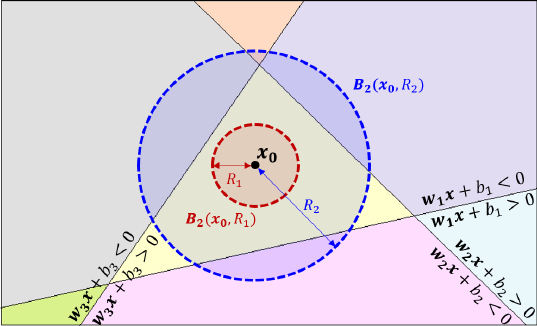

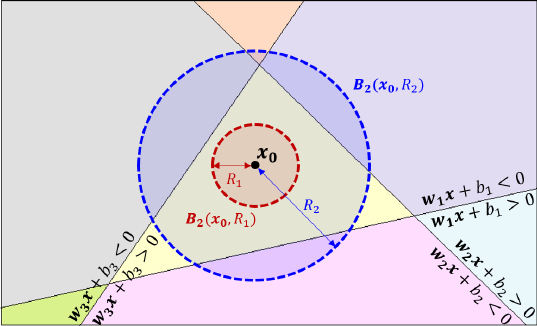

图16.25 定理16.6的插图

图16.25 定理16.6的插图

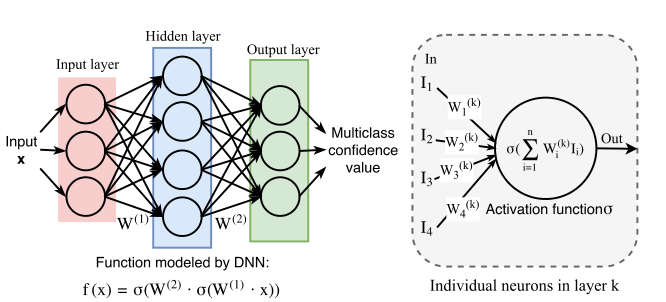

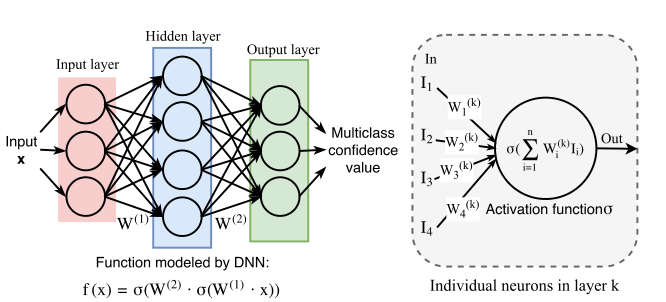

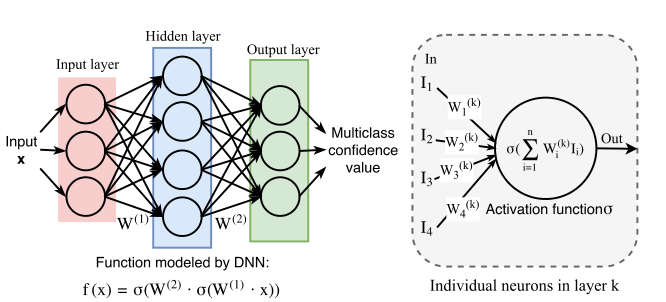

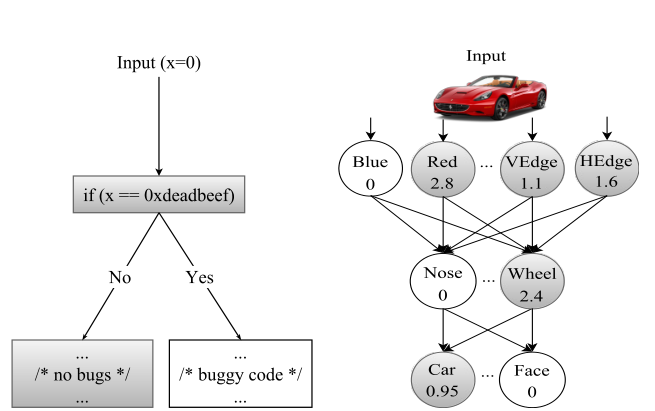

图16.27 一个简单的DNN和每个神经元执行的计算

图16.27 一个简单的DNN和每个神经元执行的计算

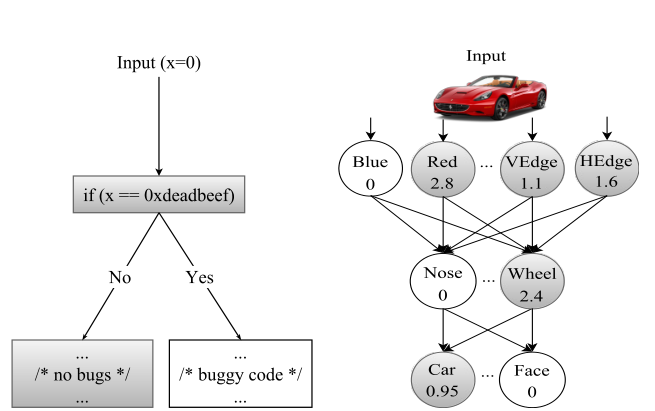

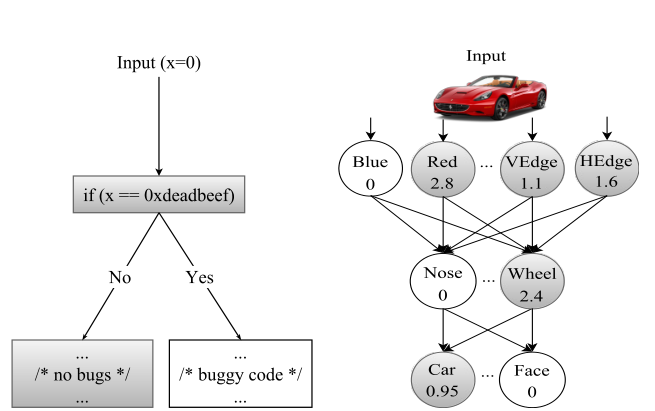

图16.28 传统程序流程和神经网络之间的比较

图16.28 传统程序流程和神经网络之间的比较

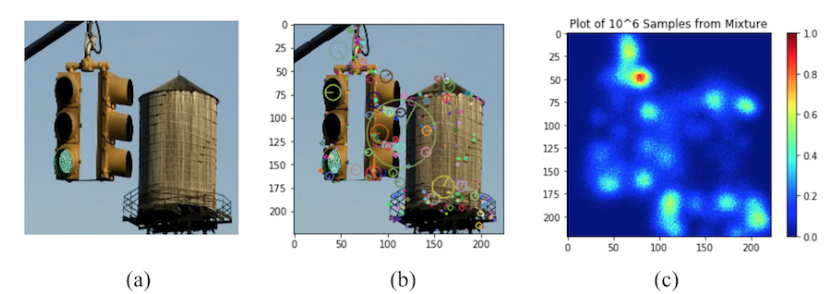

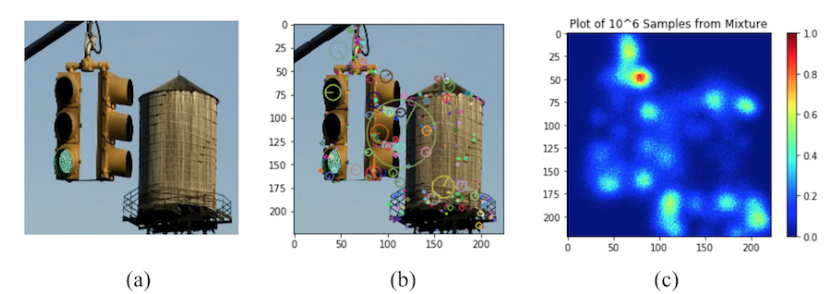

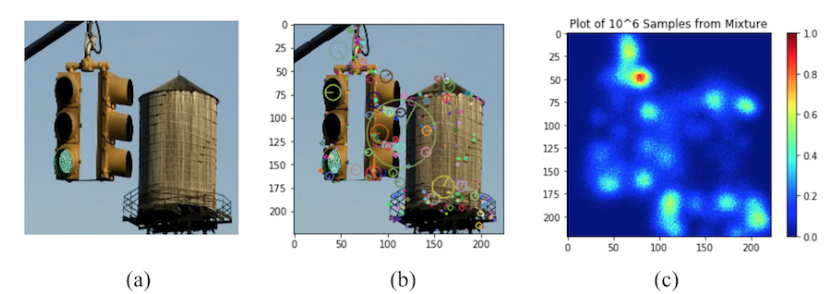

图16.34 将图像转化为显著图

图16.34 将图像转化为显著图

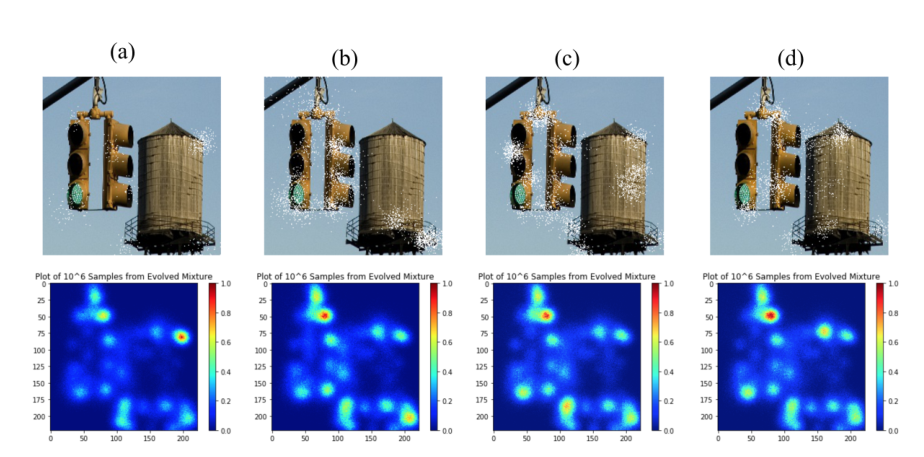

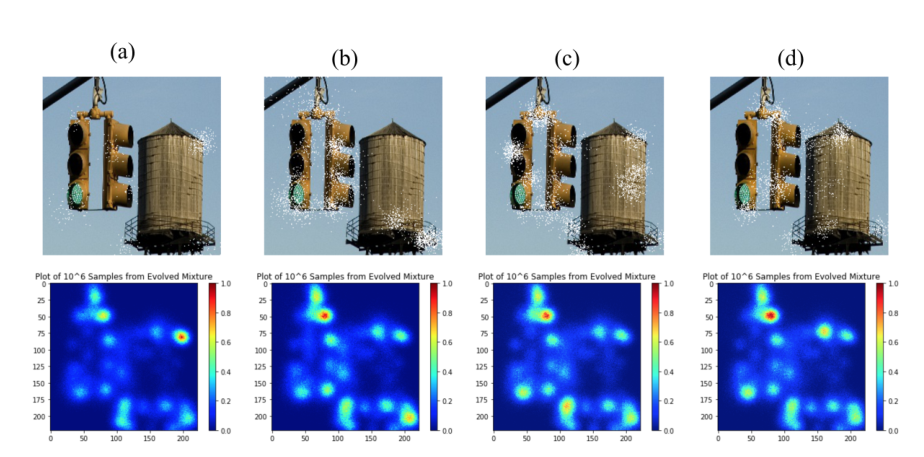

图16.35 具有不同目标类别的显着性分布演变的例证

图16.35 具有不同目标类别的显着性分布演变的例证